Veja no TensorFlow.org Veja no TensorFlow.org |  Executar no Google Colab Executar no Google Colab |  Ver no GitHub Ver no GitHub |  Baixar caderno Baixar caderno |  Veja os modelos do TF Hub Veja os modelos do TF Hub |

Este notebook mostra como ajustar modelos CropNet do TensorFlow Hub em um conjunto de dados do TFDS ou em seu próprio conjunto de dados de detecção de doenças de culturas.

Você irá:

- Carregue o conjunto de dados de mandioca do TFDS ou seus próprios dados

- Enriqueça os dados com exemplos desconhecidos (negativos) para obter um modelo mais robusto

- Aplicar aumentos de imagem aos dados

- Carregar e ajustar um modelo CropNet do TF Hub

- Exporte um modelo TFLite, pronto para ser implantado em seu aplicativo com a Biblioteca de Tarefas , MLKit ou TFLite diretamente

Importações e Dependências

Antes de começar, você precisará instalar algumas das dependências que serão necessárias, como Model Maker e a versão mais recente dos conjuntos de dados do TensorFlow.

pip install --use-deprecated=legacy-resolver tflite-model-makerpip install -U tensorflow-datasets

import matplotlib.pyplot as plt

import os

import seaborn as sns

import tensorflow as tf

import tensorflow_datasets as tfds

from tensorflow_examples.lite.model_maker.core.export_format import ExportFormat

from tensorflow_examples.lite.model_maker.core.task import image_preprocessing

from tflite_model_maker import image_classifier

from tflite_model_maker import ImageClassifierDataLoader

from tflite_model_maker.image_classifier import ModelSpec

/tmpfs/src/tf_docs_env/lib/python3.7/site-packages/tensorflow_addons/utils/ensure_tf_install.py:67: UserWarning: Tensorflow Addons supports using Python ops for all Tensorflow versions above or equal to 2.5.0 and strictly below 2.8.0 (nightly versions are not supported). The versions of TensorFlow you are currently using is 2.8.0-rc1 and is not supported. Some things might work, some things might not. If you were to encounter a bug, do not file an issue. If you want to make sure you're using a tested and supported configuration, either change the TensorFlow version or the TensorFlow Addons's version. You can find the compatibility matrix in TensorFlow Addon's readme: https://github.com/tensorflow/addons UserWarning, /tmpfs/src/tf_docs_env/lib/python3.7/site-packages/numba/core/errors.py:154: UserWarning: Insufficiently recent colorama version found. Numba requires colorama >= 0.3.9 warnings.warn(msg)

Carregar um conjunto de dados TFDS para ajustar

Vamos usar o conjunto de dados publicamente disponível da doença da folha de mandioca do TFDS.

tfds_name = 'cassava'

(ds_train, ds_validation, ds_test), ds_info = tfds.load(

name=tfds_name,

split=['train', 'validation', 'test'],

with_info=True,

as_supervised=True)

TFLITE_NAME_PREFIX = tfds_name

Ou, alternativamente, carregue seus próprios dados para ajustar

Em vez de usar um conjunto de dados TFDS, você também pode treinar com seus próprios dados. Este snippet de código mostra como carregar seu próprio conjunto de dados personalizado. Veja este link para a estrutura suportada dos dados. Um exemplo é fornecido aqui usando o conjunto de dados publicamente disponível da doença da folha de mandioca .

# data_root_dir = tf.keras.utils.get_file(

# 'cassavaleafdata.zip',

# 'https://storage.googleapis.com/emcassavadata/cassavaleafdata.zip',

# extract=True)

# data_root_dir = os.path.splitext(data_root_dir)[0] # Remove the .zip extension

# builder = tfds.ImageFolder(data_root_dir)

# ds_info = builder.info

# ds_train = builder.as_dataset(split='train', as_supervised=True)

# ds_validation = builder.as_dataset(split='validation', as_supervised=True)

# ds_test = builder.as_dataset(split='test', as_supervised=True)

Visualize amostras da divisão do trem

Vamos dar uma olhada em alguns exemplos do conjunto de dados, incluindo o ID da classe e o nome da classe para as amostras de imagem e seus rótulos.

_ = tfds.show_examples(ds_train, ds_info)

Adicione imagens a serem usadas como exemplos desconhecidos de conjuntos de dados TFDS

Adicione exemplos desconhecidos (negativos) adicionais ao conjunto de dados de treinamento e atribua um novo número de rótulo de classe desconhecido a eles. O objetivo é ter um modelo que, quando usado na prática (por exemplo, em campo), tenha a opção de prever "Desconhecido" quando constatar algo inesperado.

Abaixo, você pode ver uma lista de conjuntos de dados que serão usados para amostrar as imagens desconhecidas adicionais. Inclui 3 conjuntos de dados completamente diferentes para aumentar a diversidade. Um deles é um conjunto de dados de doença foliar do feijão, para que o modelo tenha exposição a plantas doentes que não sejam a mandioca.

UNKNOWN_TFDS_DATASETS = [{

'tfds_name': 'imagenet_v2/matched-frequency',

'train_split': 'test[:80%]',

'test_split': 'test[80%:]',

'num_examples_ratio_to_normal': 1.0,

}, {

'tfds_name': 'oxford_flowers102',

'train_split': 'train',

'test_split': 'test',

'num_examples_ratio_to_normal': 1.0,

}, {

'tfds_name': 'beans',

'train_split': 'train',

'test_split': 'test',

'num_examples_ratio_to_normal': 1.0,

}]

Os conjuntos de dados UNKNOWN também são carregados do TFDS.

# Load unknown datasets.

weights = [

spec['num_examples_ratio_to_normal'] for spec in UNKNOWN_TFDS_DATASETS

]

num_unknown_train_examples = sum(

int(w * ds_train.cardinality().numpy()) for w in weights)

ds_unknown_train = tf.data.Dataset.sample_from_datasets([

tfds.load(

name=spec['tfds_name'], split=spec['train_split'],

as_supervised=True).repeat(-1) for spec in UNKNOWN_TFDS_DATASETS

], weights).take(num_unknown_train_examples)

ds_unknown_train = ds_unknown_train.apply(

tf.data.experimental.assert_cardinality(num_unknown_train_examples))

ds_unknown_tests = [

tfds.load(

name=spec['tfds_name'], split=spec['test_split'], as_supervised=True)

for spec in UNKNOWN_TFDS_DATASETS

]

ds_unknown_test = ds_unknown_tests[0]

for ds in ds_unknown_tests[1:]:

ds_unknown_test = ds_unknown_test.concatenate(ds)

# All examples from the unknown datasets will get a new class label number.

num_normal_classes = len(ds_info.features['label'].names)

unknown_label_value = tf.convert_to_tensor(num_normal_classes, tf.int64)

ds_unknown_train = ds_unknown_train.map(lambda image, _:

(image, unknown_label_value))

ds_unknown_test = ds_unknown_test.map(lambda image, _:

(image, unknown_label_value))

# Merge the normal train dataset with the unknown train dataset.

weights = [

ds_train.cardinality().numpy(),

ds_unknown_train.cardinality().numpy()

]

ds_train_with_unknown = tf.data.Dataset.sample_from_datasets(

[ds_train, ds_unknown_train], [float(w) for w in weights])

ds_train_with_unknown = ds_train_with_unknown.apply(

tf.data.experimental.assert_cardinality(sum(weights)))

print((f"Added {ds_unknown_train.cardinality().numpy()} negative examples."

f"Training dataset has now {ds_train_with_unknown.cardinality().numpy()}"

' examples in total.'))

Added 16968 negative examples.Training dataset has now 22624 examples in total.

Aplicar aumentos

Para todas as imagens, para torná-las mais diversificadas, você aplicará alguns aumentos, como alterações em:

- Brilho

- Contraste

- Saturação

- Matiz

- Colheita

Esses tipos de aumentos ajudam a tornar o modelo mais robusto a variações nas entradas de imagem.

def random_crop_and_random_augmentations_fn(image):

# preprocess_for_train does random crop and resize internally.

image = image_preprocessing.preprocess_for_train(image)

image = tf.image.random_brightness(image, 0.2)

image = tf.image.random_contrast(image, 0.5, 2.0)

image = tf.image.random_saturation(image, 0.75, 1.25)

image = tf.image.random_hue(image, 0.1)

return image

def random_crop_fn(image):

# preprocess_for_train does random crop and resize internally.

image = image_preprocessing.preprocess_for_train(image)

return image

def resize_and_center_crop_fn(image):

image = tf.image.resize(image, (256, 256))

image = image[16:240, 16:240]

return image

no_augment_fn = lambda image: image

train_augment_fn = lambda image, label: (

random_crop_and_random_augmentations_fn(image), label)

eval_augment_fn = lambda image, label: (resize_and_center_crop_fn(image), label)

Para aplicar o aumento, ele usa o método map da classe Dataset.

ds_train_with_unknown = ds_train_with_unknown.map(train_augment_fn)

ds_validation = ds_validation.map(eval_augment_fn)

ds_test = ds_test.map(eval_augment_fn)

ds_unknown_test = ds_unknown_test.map(eval_augment_fn)

INFO:tensorflow:Use default resize_bicubic. INFO:tensorflow:Use default resize_bicubic. INFO:tensorflow:Use customized resize method bilinear INFO:tensorflow:Use customized resize method bilinear

Envolva os dados em um formato amigável ao Model Maker

Para usar esses conjuntos de dados com o Model Maker, eles precisam estar em uma classe ImageClassifierDataLoader.

label_names = ds_info.features['label'].names + ['UNKNOWN']

train_data = ImageClassifierDataLoader(ds_train_with_unknown,

ds_train_with_unknown.cardinality(),

label_names)

validation_data = ImageClassifierDataLoader(ds_validation,

ds_validation.cardinality(),

label_names)

test_data = ImageClassifierDataLoader(ds_test, ds_test.cardinality(),

label_names)

unknown_test_data = ImageClassifierDataLoader(ds_unknown_test,

ds_unknown_test.cardinality(),

label_names)

Executar treinamento

O TensorFlow Hub tem vários modelos disponíveis para Transfer Learning.

Aqui você pode escolher um e também pode continuar experimentando outros para tentar obter melhores resultados.

Se quiser experimentar ainda mais modelos, pode adicioná-los desta coleção .

Escolha um modelo básico

model_name = 'mobilenet_v3_large_100_224'

map_model_name = {

'cropnet_cassava':

'https://tfhub.dev/google/cropnet/feature_vector/cassava_disease_V1/1',

'cropnet_concat':

'https://tfhub.dev/google/cropnet/feature_vector/concat/1',

'cropnet_imagenet':

'https://tfhub.dev/google/cropnet/feature_vector/imagenet/1',

'mobilenet_v3_large_100_224':

'https://tfhub.dev/google/imagenet/mobilenet_v3_large_100_224/feature_vector/5',

}

model_handle = map_model_name[model_name]

Para ajustar o modelo, você usará o Model Maker. Isso torna a solução geral mais fácil, pois após o treinamento do modelo, ele também o converterá em TFLite.

O Model Maker faz com que essa conversão seja a melhor possível e com todas as informações necessárias para implantar facilmente o modelo no dispositivo posteriormente.

A especificação do modelo é como você informa ao Model Maker qual modelo básico você gostaria de usar.

image_model_spec = ModelSpec(uri=model_handle)

Um detalhe importante aqui é configurar train_whole_model que fará com que o modelo base seja ajustado durante o treinamento. Isso torna o processo mais lento, mas o modelo final tem uma precisão maior. A configuração de shuffle garantirá que o modelo veja os dados em uma ordem aleatória, o que é uma prática recomendada para o aprendizado do modelo.

model = image_classifier.create(

train_data,

model_spec=image_model_spec,

batch_size=128,

learning_rate=0.03,

epochs=5,

shuffle=True,

train_whole_model=True,

validation_data=validation_data)

INFO:tensorflow:Retraining the models...

INFO:tensorflow:Retraining the models...

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

hub_keras_layer_v1v2 (HubKe (None, 1280) 4226432

rasLayerV1V2)

dropout (Dropout) (None, 1280) 0

dense (Dense) (None, 6) 7686

=================================================================

Total params: 4,234,118

Trainable params: 4,209,718

Non-trainable params: 24,400

_________________________________________________________________

None

Epoch 1/5

/tmpfs/src/tf_docs_env/lib/python3.7/site-packages/keras/optimizer_v2/gradient_descent.py:102: UserWarning: The `lr` argument is deprecated, use `learning_rate` instead.

super(SGD, self).__init__(name, **kwargs)

176/176 [==============================] - 120s 488ms/step - loss: 0.8874 - accuracy: 0.9148 - val_loss: 1.1721 - val_accuracy: 0.7935

Epoch 2/5

176/176 [==============================] - 84s 444ms/step - loss: 0.7907 - accuracy: 0.9532 - val_loss: 1.0761 - val_accuracy: 0.8100

Epoch 3/5

176/176 [==============================] - 85s 441ms/step - loss: 0.7743 - accuracy: 0.9582 - val_loss: 1.0305 - val_accuracy: 0.8444

Epoch 4/5

176/176 [==============================] - 79s 409ms/step - loss: 0.7653 - accuracy: 0.9611 - val_loss: 1.0166 - val_accuracy: 0.8422

Epoch 5/5

176/176 [==============================] - 75s 402ms/step - loss: 0.7534 - accuracy: 0.9665 - val_loss: 0.9988 - val_accuracy: 0.8555

Avaliar o modelo na divisão de teste

model.evaluate(test_data)

59/59 [==============================] - 10s 81ms/step - loss: 0.9956 - accuracy: 0.8594 [0.9956456422805786, 0.8594164252281189]

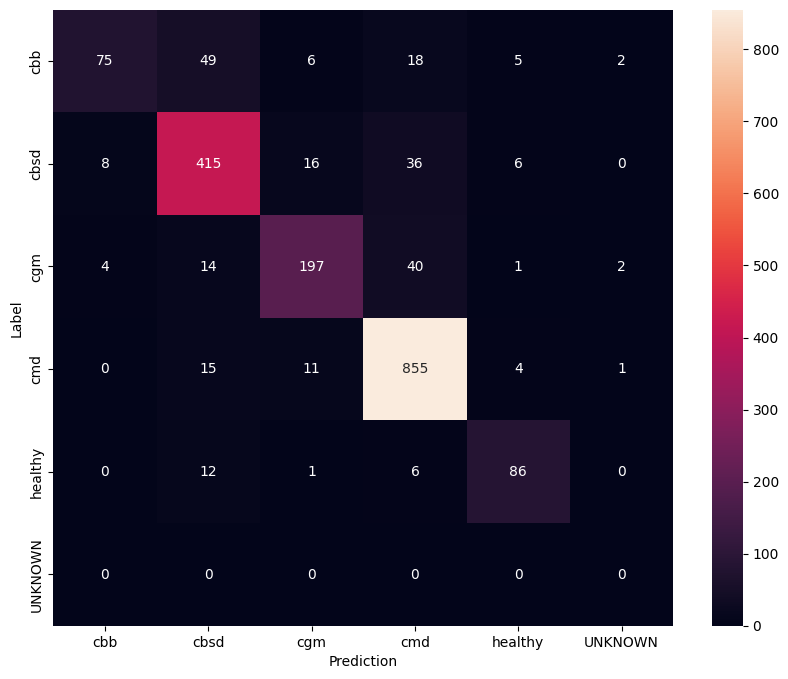

Para ter uma compreensão ainda melhor do modelo ajustado, é bom analisar a matriz de confusão. Isso mostrará com que frequência uma classe é prevista como outra.

def predict_class_label_number(dataset):

"""Runs inference and returns predictions as class label numbers."""

rev_label_names = {l: i for i, l in enumerate(label_names)}

return [

rev_label_names[o[0][0]]

for o in model.predict_top_k(dataset, batch_size=128)

]

def show_confusion_matrix(cm, labels):

plt.figure(figsize=(10, 8))

sns.heatmap(cm, xticklabels=labels, yticklabels=labels,

annot=True, fmt='g')

plt.xlabel('Prediction')

plt.ylabel('Label')

plt.show()

confusion_mtx = tf.math.confusion_matrix(

list(ds_test.map(lambda x, y: y)),

predict_class_label_number(test_data),

num_classes=len(label_names))

show_confusion_matrix(confusion_mtx, label_names)

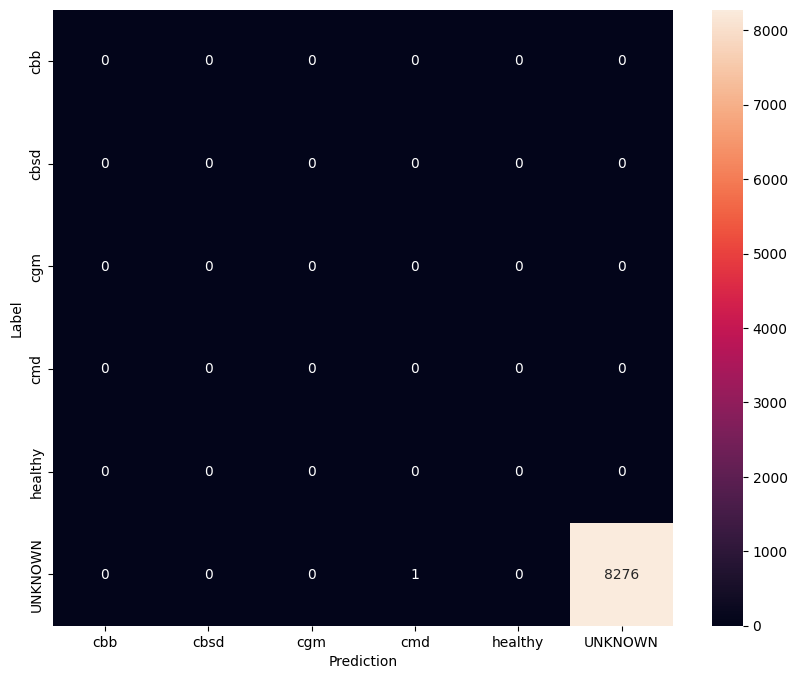

Avaliar modelo em dados de teste desconhecidos

Nesta avaliação, esperamos que o modelo tenha precisão de quase 1. Todas as imagens nas quais o modelo é testado não estão relacionadas ao conjunto de dados normal e, portanto, esperamos que o modelo preveja o rótulo de classe "Desconhecido".

model.evaluate(unknown_test_data)

259/259 [==============================] - 36s 127ms/step - loss: 0.6777 - accuracy: 0.9996 [0.677702784538269, 0.9996375441551208]

Imprima a matriz de confusão.

unknown_confusion_mtx = tf.math.confusion_matrix(

list(ds_unknown_test.map(lambda x, y: y)),

predict_class_label_number(unknown_test_data),

num_classes=len(label_names))

show_confusion_matrix(unknown_confusion_mtx, label_names)

Exporte o modelo como TFLite e SavedModel

Agora podemos exportar os modelos treinados nos formatos TFLite e SavedModel para implantação no dispositivo e uso para inferência no TensorFlow.

tflite_filename = f'{TFLITE_NAME_PREFIX}_model_{model_name}.tflite'

model.export(export_dir='.', tflite_filename=tflite_filename)

2022-01-26 12:25:57.742415: W tensorflow/python/util/util.cc:368] Sets are not currently considered sequences, but this may change in the future, so consider avoiding using them.

INFO:tensorflow:Assets written to: /tmp/tmppliqmyki/assets

INFO:tensorflow:Assets written to: /tmp/tmppliqmyki/assets

/tmpfs/src/tf_docs_env/lib/python3.7/site-packages/tensorflow/lite/python/convert.py:746: UserWarning: Statistics for quantized inputs were expected, but not specified; continuing anyway.

warnings.warn("Statistics for quantized inputs were expected, but not "

2022-01-26 12:26:07.247752: W tensorflow/compiler/mlir/lite/python/tf_tfl_flatbuffer_helpers.cc:357] Ignored output_format.

2022-01-26 12:26:07.247806: W tensorflow/compiler/mlir/lite/python/tf_tfl_flatbuffer_helpers.cc:360] Ignored drop_control_dependency.

INFO:tensorflow:Label file is inside the TFLite model with metadata.

fully_quantize: 0, inference_type: 6, input_inference_type: 3, output_inference_type: 3

INFO:tensorflow:Label file is inside the TFLite model with metadata.

INFO:tensorflow:Saving labels in /tmp/tmp_k_gr9mu/labels.txt

INFO:tensorflow:Saving labels in /tmp/tmp_k_gr9mu/labels.txt

INFO:tensorflow:TensorFlow Lite model exported successfully: ./cassava_model_mobilenet_v3_large_100_224.tflite

INFO:tensorflow:TensorFlow Lite model exported successfully: ./cassava_model_mobilenet_v3_large_100_224.tflite

# Export saved model version.

model.export(export_dir='.', export_format=ExportFormat.SAVED_MODEL)

INFO:tensorflow:Assets written to: ./saved_model/assets INFO:tensorflow:Assets written to: ./saved_model/assets

Próximos passos

O modelo que você acabou de treinar pode ser usado em dispositivos móveis e até mesmo implantado em campo!

Para baixar o modelo, clique no ícone de pasta do menu Arquivos no lado esquerdo da colab e escolha a opção de download.

A mesma técnica usada aqui pode ser aplicada a outras tarefas de doenças de plantas que podem ser mais adequadas para seu caso de uso ou qualquer outro tipo de tarefa de classificação de imagens. Se você quiser acompanhar e implantar em um aplicativo Android, continue neste guia de início rápido do Android .