Os detectores de objetos podem identificar quais de um conjunto conhecido de objetos podem estar presentes e fornecer informações sobre suas posições dentro de uma determinada imagem ou fluxo de vídeo. Um detector de objetos é treinado para detectar a presença e localização de várias classes de objetos. Por exemplo, um modelo pode ser treinado com imagens que contêm vários pedaços de fruta, juntamente com um rótulo que especifica a classe de fruta que eles representam (por exemplo, uma maçã, uma banana ou um morango) e dados especificando onde cada objeto aparece em a imagem. Consulte a introdução da detecção de objetos para obter mais informações sobre detectores de objetos.

Use a API ObjectDetector da Biblioteca de Tarefas para implantar seus detectores de objetos personalizados ou pré-treinados em seus aplicativos móveis.

Principais recursos da API ObjectDetector

Processamento de imagem de entrada, incluindo rotação, redimensionamento e conversão de espaço de cores.

Local do mapa de rótulos.

Limite de pontuação para filtrar resultados.

Resultados de detecção top-k.

Rotular lista de permissões e lista de negações.

Modelos de detector de objetos compatíveis

Os modelos a seguir são compatíveis com a API ObjectDetector .

Os modelos de detecção de objetos pré-treinados no TensorFlow Hub .

Modelos criados pelo AutoML Vision Edge Object Detection .

Modelos criados pelo TensorFlow Lite Model Maker para detector de objetos .

Modelos personalizados que atendem aos requisitos de compatibilidade do modelo .

Executar inferência em Java

Consulte o aplicativo de referência Object Detection para obter um exemplo de como usar ObjectDetector em um aplicativo Android.

Etapa 1: importar a dependência do Gradle e outras configurações

Copie o arquivo de modelo .tflite para o diretório assets do módulo Android onde o modelo será executado. Especifique que o arquivo não deve ser compactado e adicione a biblioteca do TensorFlow Lite ao arquivo build.gradle do módulo:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency (NNAPI is included)

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

Etapa 2: usando o modelo

// Initialization

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setMaxResults(1)

.build();

ObjectDetector objectDetector =

ObjectDetector.createFromFileAndOptions(

context, modelFile, options);

// Run inference

List<Detection> results = objectDetector.detect(image);

Consulte o código-fonte e o javadoc para obter mais opções para configurar ObjectDetector .

Executar inferência no iOS

Etapa 1: instalar as dependências

A Biblioteca de Tarefas oferece suporte à instalação usando CocoaPods. Certifique-se de que o CocoaPods esteja instalado em seu sistema. Consulte o guia de instalação do CocoaPods para obter instruções.

Consulte o guia CocoaPods para obter detalhes sobre como adicionar pods a um projeto Xcode.

Adicione o pod TensorFlowLiteTaskVision no Podfile.

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

Certifique-se de que o modelo .tflite que você usará para inferência esteja presente em seu pacote de aplicativos.

Etapa 2: usando o modelo

Rápido

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "ssd_mobilenet_v1",

ofType: "tflite") else { return }

let options = ObjectDetectorOptions(modelPath: modelPath)

// Configure any additional options:

// options.classificationOptions.maxResults = 3

let detector = try ObjectDetector.detector(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "cats_and_dogs.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let detectionResult = try detector.detect(mlImage: mlImage)

Objetivo C

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"ssd_mobilenet_v1" ofType:@"tflite"];

TFLObjectDetectorOptions *options = [[TFLObjectDetectorOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.classificationOptions.maxResults = 3;

TFLObjectDetector *detector = [TFLObjectDetector objectDetectorWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"dogs.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLDetectionResult *detectionResult = [detector detectWithGMLImage:gmlImage error:nil];

Consulte o código-fonte para obter mais opções para configurar o TFLObjectDetector .

Executar inferência em Python

Etapa 1: Instale o pacote pip

pip install tflite-support

Etapa 2: usando o modelo

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

detection_options = processor.DetectionOptions(max_results=2)

options = vision.ObjectDetectorOptions(base_options=base_options, detection_options=detection_options)

detector = vision.ObjectDetector.create_from_options(options)

# Alternatively, you can create an object detector in the following manner:

# detector = vision.ObjectDetector.create_from_file(model_path)

# Run inference

image = vision.TensorImage.create_from_file(image_path)

detection_result = detector.detect(image)

Consulte o código-fonte para obter mais opções para configurar ObjectDetector .

Executar inferência em C++

// Initialization

ObjectDetectorOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ObjectDetector> object_detector = ObjectDetector::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const DetectionResult result = object_detector->Detect(*frame_buffer).value();

Consulte o código-fonte para obter mais opções para configurar ObjectDetector .

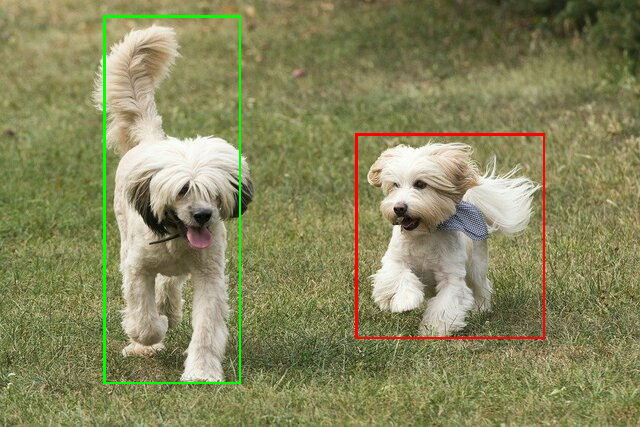

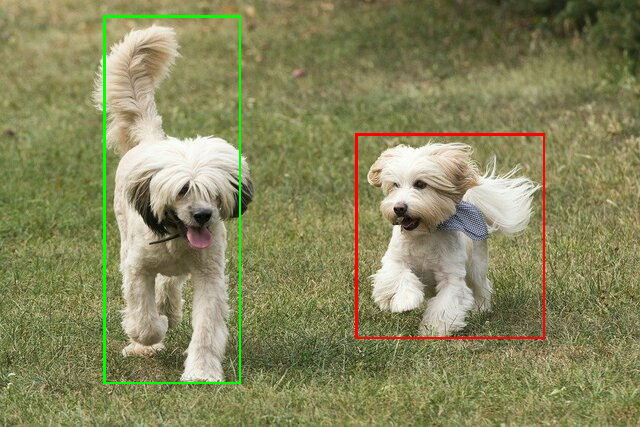

Resultados de exemplo

Aqui está um exemplo dos resultados de detecção do ssd mobilenet v1 do TensorFlow Hub.

Results:

Detection #0 (red):

Box: (x: 355, y: 133, w: 190, h: 206)

Top-1 class:

index : 17

score : 0.73828

class name : dog

Detection #1 (green):

Box: (x: 103, y: 15, w: 138, h: 369)

Top-1 class:

index : 17

score : 0.73047

class name : dog

Renderize as caixas delimitadoras na imagem de entrada:

Experimente a ferramenta de demonstração CLI simples para ObjectDetector com seu próprio modelo e dados de teste.

Requisitos de compatibilidade do modelo

A API ObjectDetector espera um modelo TFLite com metadados de modelo TFLite obrigatórios. Veja exemplos de criação de metadados para detectores de objetos usando a API TensorFlow Lite Metadata Writer .

Os modelos de detector de objetos compatíveis devem atender aos seguintes requisitos:

Tensor de imagem de entrada: (kTfLiteUInt8/kTfLiteFloat32)

- entrada de imagem de tamanho

[batch x height x width x channels]. - a inferência de lote não é suportada (o

batchdeve ser 1). - apenas entradas RGB são suportadas (os

channelsdevem ser 3). - se o tipo for kTfLiteFloat32, as NormalizationOptions devem ser anexadas aos metadados para normalização de entrada.

- entrada de imagem de tamanho

Os tensores de saída devem ser as 4 saídas de um op

DetectionPostProcess, ou seja:- Tensor de locais (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results x 4], o array interno representando caixas delimitadoras na forma [top, left, right, bottom]. - BoundingBoxProperties devem ser anexados aos metadados e devem especificar

type=BOUNDARIESe `coordinate_type=RATIO.

- tensor de tamanho

Tensor de classes (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results], cada valor representando o índice inteiro de uma classe. - mapa(s) de rótulos opcionais (mas recomendados) podem ser anexados como AssociatedFile-s com o tipo TENSOR_VALUE_LABELS, contendo um rótulo por linha. Veja o arquivo de etiqueta de exemplo . O primeiro AssociatedFile (se houver) é usado para preencher o campo

class_namedos resultados. O campodisplay_nameé preenchido a partir do AssociatedFile (se houver) cuja localidade corresponde ao campodisplay_names_localedoObjectDetectorOptionsusado no momento da criação ("en" por padrão, ou seja, inglês). Se nenhum deles estiver disponível, apenas o campo deindexdos resultados será preenchido.

- tensor de tamanho

Tensor de pontuação (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results], cada valor representando a pontuação do objeto detectado.

- tensor de tamanho

Número do tensor de detecção (kTfLiteFloat32)

- integer num_results como um tensor de tamanho

[1].

- integer num_results como um tensor de tamanho

- Tensor de locais (kTfLiteFloat32)

Os detectores de objetos podem identificar quais de um conjunto conhecido de objetos podem estar presentes e fornecer informações sobre suas posições dentro de uma determinada imagem ou fluxo de vídeo. Um detector de objetos é treinado para detectar a presença e localização de várias classes de objetos. Por exemplo, um modelo pode ser treinado com imagens que contêm vários pedaços de fruta, juntamente com um rótulo que especifica a classe de fruta que eles representam (por exemplo, uma maçã, uma banana ou um morango) e dados especificando onde cada objeto aparece em a imagem. Consulte a introdução da detecção de objetos para obter mais informações sobre detectores de objetos.

Use a API ObjectDetector da Biblioteca de Tarefas para implantar seus detectores de objetos personalizados ou pré-treinados em seus aplicativos móveis.

Principais recursos da API ObjectDetector

Processamento de imagem de entrada, incluindo rotação, redimensionamento e conversão de espaço de cores.

Local do mapa de rótulos.

Limite de pontuação para filtrar resultados.

Resultados de detecção top-k.

Rotular lista de permissões e lista de negações.

Modelos de detector de objetos compatíveis

Os modelos a seguir são compatíveis com a API ObjectDetector .

Os modelos de detecção de objetos pré-treinados no TensorFlow Hub .

Modelos criados pelo AutoML Vision Edge Object Detection .

Modelos criados pelo TensorFlow Lite Model Maker para detector de objetos .

Modelos personalizados que atendem aos requisitos de compatibilidade do modelo .

Executar inferência em Java

Consulte o aplicativo de referência Object Detection para obter um exemplo de como usar ObjectDetector em um aplicativo Android.

Etapa 1: importar a dependência do Gradle e outras configurações

Copie o arquivo de modelo .tflite para o diretório assets do módulo Android onde o modelo será executado. Especifique que o arquivo não deve ser compactado e adicione a biblioteca do TensorFlow Lite ao arquivo build.gradle do módulo:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency (NNAPI is included)

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

Etapa 2: usando o modelo

// Initialization

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setMaxResults(1)

.build();

ObjectDetector objectDetector =

ObjectDetector.createFromFileAndOptions(

context, modelFile, options);

// Run inference

List<Detection> results = objectDetector.detect(image);

Consulte o código-fonte e o javadoc para obter mais opções para configurar ObjectDetector .

Executar inferência no iOS

Etapa 1: instalar as dependências

A Biblioteca de Tarefas oferece suporte à instalação usando CocoaPods. Certifique-se de que o CocoaPods esteja instalado em seu sistema. Consulte o guia de instalação do CocoaPods para obter instruções.

Consulte o guia CocoaPods para obter detalhes sobre como adicionar pods a um projeto Xcode.

Adicione o pod TensorFlowLiteTaskVision no Podfile.

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

Certifique-se de que o modelo .tflite que você usará para inferência esteja presente em seu pacote de aplicativos.

Etapa 2: usando o modelo

Rápido

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "ssd_mobilenet_v1",

ofType: "tflite") else { return }

let options = ObjectDetectorOptions(modelPath: modelPath)

// Configure any additional options:

// options.classificationOptions.maxResults = 3

let detector = try ObjectDetector.detector(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "cats_and_dogs.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let detectionResult = try detector.detect(mlImage: mlImage)

Objetivo C

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"ssd_mobilenet_v1" ofType:@"tflite"];

TFLObjectDetectorOptions *options = [[TFLObjectDetectorOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.classificationOptions.maxResults = 3;

TFLObjectDetector *detector = [TFLObjectDetector objectDetectorWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"dogs.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLDetectionResult *detectionResult = [detector detectWithGMLImage:gmlImage error:nil];

Consulte o código-fonte para obter mais opções para configurar o TFLObjectDetector .

Executar inferência em Python

Etapa 1: Instale o pacote pip

pip install tflite-support

Etapa 2: usando o modelo

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

detection_options = processor.DetectionOptions(max_results=2)

options = vision.ObjectDetectorOptions(base_options=base_options, detection_options=detection_options)

detector = vision.ObjectDetector.create_from_options(options)

# Alternatively, you can create an object detector in the following manner:

# detector = vision.ObjectDetector.create_from_file(model_path)

# Run inference

image = vision.TensorImage.create_from_file(image_path)

detection_result = detector.detect(image)

Consulte o código-fonte para obter mais opções para configurar ObjectDetector .

Executar inferência em C++

// Initialization

ObjectDetectorOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ObjectDetector> object_detector = ObjectDetector::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const DetectionResult result = object_detector->Detect(*frame_buffer).value();

Consulte o código-fonte para obter mais opções para configurar ObjectDetector .

Resultados de exemplo

Aqui está um exemplo dos resultados de detecção do ssd mobilenet v1 do TensorFlow Hub.

Results:

Detection #0 (red):

Box: (x: 355, y: 133, w: 190, h: 206)

Top-1 class:

index : 17

score : 0.73828

class name : dog

Detection #1 (green):

Box: (x: 103, y: 15, w: 138, h: 369)

Top-1 class:

index : 17

score : 0.73047

class name : dog

Renderize as caixas delimitadoras na imagem de entrada:

Experimente a ferramenta de demonstração CLI simples para ObjectDetector com seu próprio modelo e dados de teste.

Requisitos de compatibilidade do modelo

A API ObjectDetector espera um modelo TFLite com metadados de modelo TFLite obrigatórios. Veja exemplos de criação de metadados para detectores de objetos usando a API TensorFlow Lite Metadata Writer .

Os modelos de detector de objetos compatíveis devem atender aos seguintes requisitos:

Tensor de imagem de entrada: (kTfLiteUInt8/kTfLiteFloat32)

- entrada de imagem de tamanho

[batch x height x width x channels]. - a inferência de lote não é suportada (o

batchdeve ser 1). - apenas entradas RGB são suportadas (os

channelsdevem ser 3). - se o tipo for kTfLiteFloat32, as NormalizationOptions devem ser anexadas aos metadados para normalização de entrada.

- entrada de imagem de tamanho

Os tensores de saída devem ser as 4 saídas de um op

DetectionPostProcess, ou seja:- Tensor de locais (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results x 4], o array interno representando caixas delimitadoras na forma [top, left, right, bottom]. - BoundingBoxProperties devem ser anexados aos metadados e devem especificar

type=BOUNDARIESe `coordinate_type=RATIO.

- tensor de tamanho

Tensor de classes (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results], cada valor representando o índice inteiro de uma classe. - mapa(s) de rótulos opcionais (mas recomendados) podem ser anexados como AssociatedFile-s com o tipo TENSOR_VALUE_LABELS, contendo um rótulo por linha. Veja o arquivo de etiqueta de exemplo . O primeiro AssociatedFile (se houver) é usado para preencher o campo

class_namedos resultados. O campodisplay_nameé preenchido a partir do AssociatedFile (se houver) cuja localidade corresponde ao campodisplay_names_localedoObjectDetectorOptionsusado no momento da criação ("en" por padrão, ou seja, inglês). Se nenhum deles estiver disponível, apenas o campo deindexdos resultados será preenchido.

- tensor de tamanho

Tensor de pontuação (kTfLiteFloat32)

- tensor de tamanho

[1 x num_results], cada valor representando a pontuação do objeto detectado.

- tensor de tamanho

Número do tensor de detecção (kTfLiteFloat32)

- integer num_results como um tensor de tamanho

[1].

- integer num_results como um tensor de tamanho

- Tensor de locais (kTfLiteFloat32)