একটি টেনসরফ্লো লাইট প্রতিনিধি কি?

একটি টেনসরফ্লো লাইট প্রতিনিধি আপনাকে আপনার মডেলগুলি (আংশিক বা সম্পূর্ণ) অন্য নির্বাহকের উপর চালানোর অনুমতি দেয়। এই প্রক্রিয়াটি অনুমানের জন্য বিভিন্ন ধরনের অন-ডিভাইস এক্সিলারেটর যেমন GPU বা Edge TPU (টেনসর প্রসেসিং ইউনিট) ব্যবহার করতে পারে। এটি বিকাশকারীদের ডিফল্ট TFLite থেকে অনুমানের গতি বাড়ানোর জন্য একটি নমনীয় এবং ডিকপল পদ্ধতি প্রদান করে।

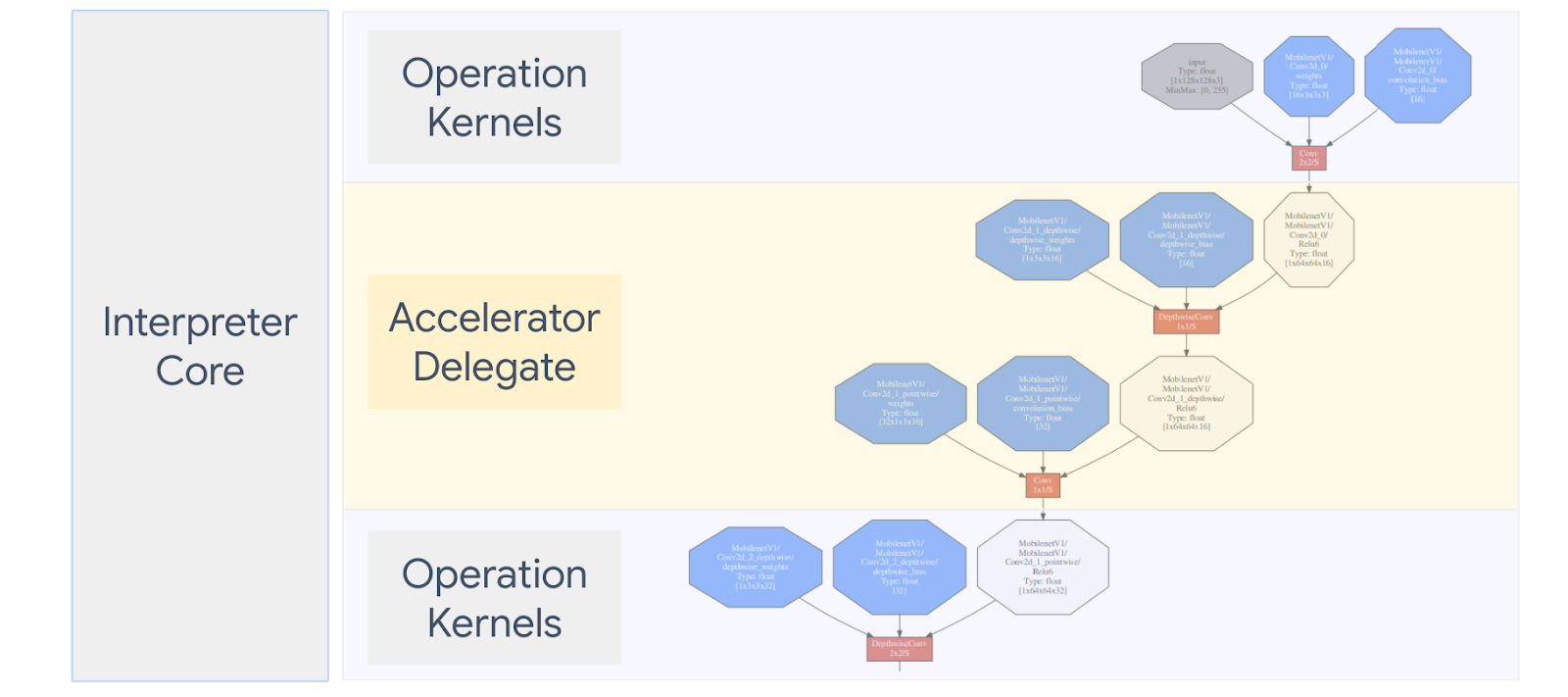

নীচের চিত্রটি প্রতিনিধিদের সংক্ষিপ্ত করে, নীচের বিভাগে আরও বিশদ বিবরণ।

আমি কখন একটি কাস্টম প্রতিনিধি তৈরি করব?

টেনসরফ্লো লাইটে জিপিইউ, ডিএসপি, এজটিপিইউ এবং অ্যান্ড্রয়েড এনএনএপিআই-এর মতো ফ্রেমওয়ার্কের মতো টার্গেট অ্যাক্সিলারেটরের জন্য বিভিন্ন ধরনের প্রতিনিধি রয়েছে।

নিম্নলিখিত পরিস্থিতিতে আপনার নিজস্ব প্রতিনিধি তৈরি করা দরকারী:

- আপনি একটি নতুন এমএল ইনফারেন্স ইঞ্জিন সংহত করতে চান যা কোনো বিদ্যমান প্রতিনিধি দ্বারা সমর্থিত নয়।

- আপনার কাছে একটি কাস্টম হার্ডওয়্যার অ্যাক্সিলারেটর রয়েছে যা পরিচিত পরিস্থিতিগুলির জন্য রানটাইম উন্নত করে৷

- আপনি সিপিইউ অপ্টিমাইজেশন তৈরি করছেন (যেমন অপারেটর ফিউজিং) যা নির্দিষ্ট মডেলের গতি বাড়াতে পারে।

প্রতিনিধিরা কিভাবে কাজ করে?

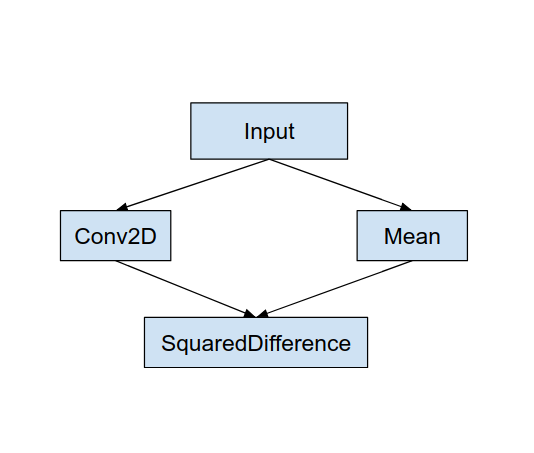

একটি সাধারণ মডেল গ্রাফ বিবেচনা করুন যেমন নিম্নলিখিত, এবং একটি প্রতিনিধি "MyDelegate" যা Conv2D এবং গড় অপারেশনগুলির জন্য দ্রুত বাস্তবায়ন করে৷

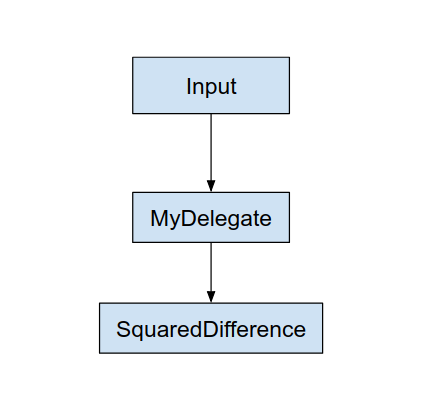

এই "MyDelegate" প্রয়োগ করার পরে, মূল TensorFlow Lite গ্রাফটি নিম্নলিখিত মত আপডেট করা হবে:

উপরের গ্রাফটি প্রাপ্ত হয়েছে কারণ TensorFlow Lite দুটি নিয়ম অনুসরণ করে মূল গ্রাফটিকে বিভক্ত করে:

- নির্দিষ্ট ক্রিয়াকলাপ যা প্রতিনিধি দ্বারা পরিচালনা করা যেতে পারে সেগুলিকে একটি পার্টিশনে রাখা হয় যখন এখনও অপারেশনগুলির মধ্যে মূল কম্পিউটিং ওয়ার্কফ্লো নির্ভরতাকে সন্তুষ্ট করে।

- প্রতিটি অর্পিত পার্টিশনে শুধুমাত্র ইনপুট এবং আউটপুট নোড থাকে যা প্রতিনিধি দ্বারা পরিচালিত হয় না।

প্রতিনিধি দ্বারা পরিচালিত প্রতিটি পার্টিশন মূল গ্রাফে একটি প্রতিনিধি নোড দ্বারা প্রতিস্থাপিত হয় (এটি একটি প্রতিনিধি কার্নেলও বলা যেতে পারে) যা তার আহ্বান কলে পার্টিশনটিকে মূল্যায়ন করে।

মডেলের উপর নির্ভর করে, চূড়ান্ত গ্রাফটি এক বা একাধিক নোডের সাথে শেষ হতে পারে, পরবর্তীটির অর্থ হল কিছু অপ্স প্রতিনিধি দ্বারা সমর্থিত নয়। সাধারণভাবে, আপনি একাধিক পার্টিশন প্রতিনিধি দ্বারা পরিচালনা করতে চান না, কারণ প্রতিবার আপনি প্রতিনিধি থেকে মূল গ্রাফে স্যুইচ করার সময়, অর্পিত সাবগ্রাফ থেকে মূল গ্রাফে ফলাফলগুলি পাস করার জন্য একটি ওভারহেড থাকে যা মেমরির কারণে ফলাফল হয়। অনুলিপি (উদাহরণস্বরূপ, GPU থেকে CPU)। এই ধরনের ওভারহেড কর্মক্ষমতা লাভ অফসেট হতে পারে বিশেষ করে যখন প্রচুর পরিমাণে মেমরি কপি থাকে।

আপনার নিজস্ব কাস্টম প্রতিনিধি বাস্তবায়ন

একটি প্রতিনিধি যোগ করার পছন্দের পদ্ধতি হল SimpleDelegate API ব্যবহার করা।

একটি নতুন প্রতিনিধি তৈরি করতে, আপনাকে 2টি ইন্টারফেস বাস্তবায়ন করতে হবে এবং ইন্টারফেস পদ্ধতিগুলির জন্য আপনার নিজস্ব বাস্তবায়ন প্রদান করতে হবে।

1 - SimpleDelegateInterface

এই শ্রেণী প্রতিনিধির ক্ষমতা উপস্থাপন করে, কোন ক্রিয়াকলাপগুলি সমর্থিত, এবং একটি কার্নেল তৈরির জন্য একটি ফ্যাক্টরি ক্লাস যা অর্পিত গ্রাফকে এনক্যাপসুলেট করে। আরো বিস্তারিত জানার জন্য, এই C++ হেডার ফাইলে সংজ্ঞায়িত ইন্টারফেস দেখুন। কোডের মন্তব্যগুলি প্রতিটি API বিস্তারিতভাবে ব্যাখ্যা করে।

2 - SimpleDelegateKernelInterface

এই ক্লাসটি ডেলিগেটেড পার্টিশন শুরু করার/প্রস্তুত করার/এবং চালানোর জন্য যুক্তিকে এনক্যাপসুলেট করে।

এটা আছে: ( সংজ্ঞা দেখুন)

- Init(...): যেটিকে একবার বলা হবে যেকোন এক-সময়ের ইনিশিয়ালাইজেশন করতে।

- প্রস্তুত করুন(...): এই নোডের প্রতিটি ভিন্ন উদাহরণের জন্য বলা হয়েছে - আপনার একাধিক অর্পিত পার্টিশন থাকলে এটি ঘটে। সাধারণত আপনি এখানে মেমরি বরাদ্দ করতে চান, যেহেতু প্রতিবার টেনসরের আকার পরিবর্তন করার সময় এটিকে বলা হবে।

- আহ্বান (...): যা অনুমান করার জন্য বলা হবে।

উদাহরণ

এই উদাহরণে, আপনি একটি খুব সাধারণ প্রতিনিধি তৈরি করবেন যা শুধুমাত্র ফ্লোট 32 টেনসরের সাথে শুধুমাত্র 2 ধরনের অপারেশন (ADD) এবং (SUB) সমর্থন করতে পারে।

// MyDelegate implements the interface of SimpleDelegateInterface.

// This holds the Delegate capabilities.

class MyDelegate : public SimpleDelegateInterface {

public:

bool IsNodeSupportedByDelegate(const TfLiteRegistration* registration,

const TfLiteNode* node,

TfLiteContext* context) const override {

// Only supports Add and Sub ops.

if (kTfLiteBuiltinAdd != registration->builtin_code &&

kTfLiteBuiltinSub != registration->builtin_code)

return false;

// This delegate only supports float32 types.

for (int i = 0; i < node->inputs->size; ++i) {

auto& tensor = context->tensors[node->inputs->data[i]];

if (tensor.type != kTfLiteFloat32) return false;

}

return true;

}

TfLiteStatus Initialize(TfLiteContext* context) override { return kTfLiteOk; }

const char* Name() const override {

static constexpr char kName[] = "MyDelegate";

return kName;

}

std::unique_ptr<SimpleDelegateKernelInterface> CreateDelegateKernelInterface()

override {

return std::make_unique<MyDelegateKernel>();

}

};

এর পরে, SimpleDelegateKernelInterface থেকে উত্তরাধিকারসূত্রে আপনার নিজস্ব প্রতিনিধি কার্নেল তৈরি করুন

// My delegate kernel.

class MyDelegateKernel : public SimpleDelegateKernelInterface {

public:

TfLiteStatus Init(TfLiteContext* context,

const TfLiteDelegateParams* params) override {

// Save index to all nodes which are part of this delegate.

inputs_.resize(params->nodes_to_replace->size);

outputs_.resize(params->nodes_to_replace->size);

builtin_code_.resize(params->nodes_to_replace->size);

for (int i = 0; i < params->nodes_to_replace->size; ++i) {

const int node_index = params->nodes_to_replace->data[i];

// Get this node information.

TfLiteNode* delegated_node = nullptr;

TfLiteRegistration* delegated_node_registration = nullptr;

TF_LITE_ENSURE_EQ(

context,

context->GetNodeAndRegistration(context, node_index, &delegated_node,

&delegated_node_registration),

kTfLiteOk);

inputs_[i].push_back(delegated_node->inputs->data[0]);

inputs_[i].push_back(delegated_node->inputs->data[1]);

outputs_[i].push_back(delegated_node->outputs->data[0]);

builtin_code_[i] = delegated_node_registration->builtin_code;

}

return kTfLiteOk;

}

TfLiteStatus Prepare(TfLiteContext* context, TfLiteNode* node) override {

return kTfLiteOk;

}

TfLiteStatus Eval(TfLiteContext* context, TfLiteNode* node) override {

// Evaluate the delegated graph.

// Here we loop over all the delegated nodes.

// We know that all the nodes are either ADD or SUB operations and the

// number of nodes equals ''inputs_.size()'' and inputs[i] is a list of

// tensor indices for inputs to node ''i'', while outputs_[i] is the list of

// outputs for node

// ''i''. Note, that it is intentional we have simple implementation as this

// is for demonstration.

for (int i = 0; i < inputs_.size(); ++i) {

// Get the node input tensors.

// Add/Sub operation accepts 2 inputs.

auto& input_tensor_1 = context->tensors[inputs_[i][0]];

auto& input_tensor_2 = context->tensors[inputs_[i][1]];

auto& output_tensor = context->tensors[outputs_[i][0]];

TF_LITE_ENSURE_EQ(

context,

ComputeResult(context, builtin_code_[i], &input_tensor_1,

&input_tensor_2, &output_tensor),

kTfLiteOk);

}

return kTfLiteOk;

}

private:

// Computes the result of addition of 'input_tensor_1' and 'input_tensor_2'

// and store the result in 'output_tensor'.

TfLiteStatus ComputeResult(TfLiteContext* context, int builtin_code,

const TfLiteTensor* input_tensor_1,

const TfLiteTensor* input_tensor_2,

TfLiteTensor* output_tensor) {

if (NumElements(input_tensor_1) != NumElements(input_tensor_2) ||

NumElements(input_tensor_1) != NumElements(output_tensor)) {

return kTfLiteDelegateError;

}

// This code assumes no activation, and no broadcasting needed (both inputs

// have the same size).

auto* input_1 = GetTensorData<float>(input_tensor_1);

auto* input_2 = GetTensorData<float>(input_tensor_2);

auto* output = GetTensorData<float>(output_tensor);

for (int i = 0; i < NumElements(input_tensor_1); ++i) {

if (builtin_code == kTfLiteBuiltinAdd)

output[i] = input_1[i] + input_2[i];

else

output[i] = input_1[i] - input_2[i];

}

return kTfLiteOk;

}

// Holds the indices of the input/output tensors.

// inputs_[i] is list of all input tensors to node at index 'i'.

// outputs_[i] is list of all output tensors to node at index 'i'.

std::vector<std::vector<int>> inputs_, outputs_;

// Holds the builtin code of the ops.

// builtin_code_[i] is the type of node at index 'i'

std::vector<int> builtin_code_;

};

বেঞ্চমার্ক এবং নতুন প্রতিনিধি মূল্যায়ন

TFLite এর একটি সেট টুল রয়েছে যা আপনি একটি TFLite মডেলের বিরুদ্ধে দ্রুত পরীক্ষা করতে পারেন।

- মডেল বেঞ্চমার্ক টুল : টুলটি একটি TFLite মডেল নেয়, এলোমেলো ইনপুট তৈরি করে এবং তারপরে নির্দিষ্ট সংখ্যক রানের জন্য বারবার মডেলটি চালায়। এটি শেষে সমষ্টিগত লেটেন্সি পরিসংখ্যান প্রিন্ট করে।

- ইনফারেন্স ডিফ টুল : একটি প্রদত্ত মডেলের জন্য, টুলটি এলোমেলো গাউসিয়ান ডেটা তৈরি করে এবং এটি দুটি ভিন্ন TFLite ইন্টারপ্রেটারের মাধ্যমে পাস করে, একটি চলমান একক থ্রেডেড CPU কার্নেল এবং অন্যটি ব্যবহারকারী-সংজ্ঞায়িত স্পেক ব্যবহার করে। এটি প্রতি-উপাদানের ভিত্তিতে প্রতিটি দোভাষী থেকে আউটপুট টেনসরের মধ্যে পরম পার্থক্য পরিমাপ করে। এই টুলটি নির্ভুলতা সমস্যা ডিবাগ করার জন্যও সহায়ক হতে পারে।

- ইমেজ শ্রেণীবিভাগ এবং বস্তু সনাক্তকরণের জন্য টাস্ক নির্দিষ্ট মূল্যায়ন সরঞ্জাম রয়েছে। এই টুলস এখানে পাওয়া যাবে

এছাড়াও, TFLite-এ কার্নেল এবং অপ ইউনিট পরীক্ষার একটি বড় সেট রয়েছে যা নতুন প্রতিনিধিকে আরও কভারেজ সহ পরীক্ষা করতে এবং নিয়মিত TFLite সম্পাদনের পথটি ভেঙে না যায় তা নিশ্চিত করতে পুনরায় ব্যবহার করা যেতে পারে।

নতুন প্রতিনিধিদের জন্য TFLite পরীক্ষা এবং টুলিং পুনরায় ব্যবহার করার জন্য, আপনি নিম্নলিখিত দুটি বিকল্পের যে কোনো একটি ব্যবহার করতে পারেন:

- ডেলিগেট রেজিস্ট্রার মেকানিজম ব্যবহার করুন।

- এক্সটার্নাল ডেলিগেট মেকানিজম ব্যবহার করুন।

সেরা পন্থা নির্বাচন

উভয় পন্থা নিচে বিস্তারিত হিসাবে কয়েকটি পরিবর্তন প্রয়োজন. যাইহোক, প্রথম পদ্ধতিটি প্রতিনিধিকে স্থিতিশীলভাবে সংযুক্ত করে এবং পরীক্ষা, বেঞ্চমার্কিং এবং মূল্যায়ন সরঞ্জামগুলি পুনর্নির্মাণের প্রয়োজন। বিপরীতে, দ্বিতীয়টি প্রতিনিধিকে একটি ভাগ করা লাইব্রেরি হিসাবে তৈরি করে এবং আপনাকে ভাগ করা লাইব্রেরি থেকে তৈরি/মুছে ফেলার পদ্ধতিগুলিকে প্রকাশ করতে হবে।

ফলস্বরূপ, এক্সটার্নাল-ডেলিগেট মেকানিজম TFLite-এর পূর্ব-নির্মিত Tensorflow Lite টুলিং বাইনারিগুলির সাথে কাজ করবে। তবে এটি কম স্পষ্ট এবং স্বয়ংক্রিয় ইন্টিগ্রেশন পরীক্ষায় সেট আপ করা আরও জটিল হতে পারে। ভাল স্পষ্টতার জন্য প্রতিনিধি রেজিস্ট্রার পদ্ধতি ব্যবহার করুন.

বিকল্প 1: লিভারেজ ডেলিগেট রেজিস্ট্রার

প্রতিনিধি রেজিস্ট্রার প্রতিনিধি প্রদানকারীদের একটি তালিকা রাখে, যার প্রত্যেকটি কমান্ড-লাইন পতাকাগুলির উপর ভিত্তি করে TFLite প্রতিনিধি তৈরি করার একটি সহজ উপায় প্রদান করে এবং তাই টুলিংয়ের জন্য সুবিধাজনক। উপরে উল্লিখিত সমস্ত Tensorflow Lite টুলগুলিতে নতুন প্রতিনিধিকে প্লাগ ইন করতে, আপনি প্রথমে এই মত একটি নতুন প্রতিনিধি প্রদানকারী তৈরি করুন এবং তারপর BUILD নিয়মে শুধুমাত্র কয়েকটি পরিবর্তন করুন৷ এই ইন্টিগ্রেশন প্রক্রিয়ার একটি সম্পূর্ণ উদাহরণ নীচে দেখানো হয়েছে (এবং কোড এখানে পাওয়া যাবে)।

ধরে নিচ্ছি যে আপনার কাছে একটি প্রতিনিধি রয়েছে যা SimpleDelegate APIs প্রয়োগ করে এবং এই 'ডামি' প্রতিনিধি তৈরি/মুছে ফেলার জন্য বহিরাগত "C" APIগুলি নীচে দেখানো হয়েছে:

// Returns default options for DummyDelegate.

DummyDelegateOptions TfLiteDummyDelegateOptionsDefault();

// Creates a new delegate instance that need to be destroyed with

// `TfLiteDummyDelegateDelete` when delegate is no longer used by TFLite.

// When `options` is set to `nullptr`, the above default values are used:

TfLiteDelegate* TfLiteDummyDelegateCreate(const DummyDelegateOptions* options);

// Destroys a delegate created with `TfLiteDummyDelegateCreate` call.

void TfLiteDummyDelegateDelete(TfLiteDelegate* delegate);

বেঞ্চমার্ক টুল এবং ইনফারেন্স টুলের সাথে "ডামি ডেলিগেট" সংহত করতে, নীচের মত একটি প্রতিনিধি প্রদানকারীকে সংজ্ঞায়িত করুন:

class DummyDelegateProvider : public DelegateProvider {

public:

DummyDelegateProvider() {

default_params_.AddParam("use_dummy_delegate",

ToolParam::Create<bool>(false));

}

std::vector<Flag> CreateFlags(ToolParams* params) const final;

void LogParams(const ToolParams& params) const final;

TfLiteDelegatePtr CreateTfLiteDelegate(const ToolParams& params) const final;

std::string GetName() const final { return "DummyDelegate"; }

};

REGISTER_DELEGATE_PROVIDER(DummyDelegateProvider);

std::vector<Flag> DummyDelegateProvider::CreateFlags(ToolParams* params) const {

std::vector<Flag> flags = {CreateFlag<bool>("use_dummy_delegate", params,

"use the dummy delegate.")};

return flags;

}

void DummyDelegateProvider::LogParams(const ToolParams& params) const {

TFLITE_LOG(INFO) << "Use dummy test delegate : ["

<< params.Get<bool>("use_dummy_delegate") << "]";

}

TfLiteDelegatePtr DummyDelegateProvider::CreateTfLiteDelegate(

const ToolParams& params) const {

if (params.Get<bool>("use_dummy_delegate")) {

auto default_options = TfLiteDummyDelegateOptionsDefault();

return TfLiteDummyDelegateCreateUnique(&default_options);

}

return TfLiteDelegatePtr(nullptr, [](TfLiteDelegate*) {});

}

BUILD নিয়মের সংজ্ঞাগুলি গুরুত্বপূর্ণ কারণ আপনাকে নিশ্চিত করতে হবে যে লাইব্রেরিটি সর্বদা সংযুক্ত থাকে এবং অপ্টিমাইজার দ্বারা বাদ না যায়।

#### The following are for using the dummy test delegate in TFLite tooling ####

cc_library(

name = "dummy_delegate_provider",

srcs = ["dummy_delegate_provider.cc"],

copts = tflite_copts(),

deps = [

":dummy_delegate",

"//tensorflow/lite/tools/delegates:delegate_provider_hdr",

],

alwayslink = 1, # This is required so the optimizer doesn't optimize the library away.

)

এখন আপনার BUILD ফাইলে এই দুটি মোড়কের নিয়ম যোগ করুন বেঞ্চমার্ক টুল এবং ইনফারেন্স টুল, এবং অন্যান্য মূল্যায়ন টুলের একটি সংস্করণ তৈরি করতে, যা আপনার নিজস্ব প্রতিনিধির সাথে চলতে পারে।

cc_binary(

name = "benchmark_model_plus_dummy_delegate",

copts = tflite_copts(),

linkopts = task_linkopts(),

deps = [

":dummy_delegate_provider",

"//tensorflow/lite/tools/benchmark:benchmark_model_main",

],

)

cc_binary(

name = "inference_diff_plus_dummy_delegate",

copts = tflite_copts(),

linkopts = task_linkopts(),

deps = [

":dummy_delegate_provider",

"//tensorflow/lite/tools/evaluation/tasks:task_executor_main",

"//tensorflow/lite/tools/evaluation/tasks/inference_diff:run_eval_lib",

],

)

cc_binary(

name = "imagenet_classification_eval_plus_dummy_delegate",

copts = tflite_copts(),

linkopts = task_linkopts(),

deps = [

":dummy_delegate_provider",

"//tensorflow/lite/tools/evaluation/tasks:task_executor_main",

"//tensorflow/lite/tools/evaluation/tasks/imagenet_image_classification:run_eval_lib",

],

)

cc_binary(

name = "coco_object_detection_eval_plus_dummy_delegate",

copts = tflite_copts(),

linkopts = task_linkopts(),

deps = [

":dummy_delegate_provider",

"//tensorflow/lite/tools/evaluation/tasks:task_executor_main",

"//tensorflow/lite/tools/evaluation/tasks/coco_object_detection:run_eval_lib",

],

)

আপনি এখানে বর্ণিত হিসাবে TFLite কার্নেল পরীক্ষায় এই প্রতিনিধি প্রদানকারীকে প্লাগ ইন করতে পারেন।

বিকল্প 2: বহিরাগত প্রতিনিধির সুবিধা নিন

এই বিকল্পে, আপনি প্রথমে একটি বাহ্যিক প্রতিনিধি অ্যাডাপ্টার তৈরি করুন external_delegate_adaptor.cc নীচে দেখানো হিসাবে। দ্রষ্টব্য, এই পদ্ধতিটি বিকল্প 1 এর তুলনায় সামান্য কম পছন্দ করা হয়েছে যেমনটি উপরে উল্লিখিত হয়েছে ।

TfLiteDelegate* CreateDummyDelegateFromOptions(char** options_keys,

char** options_values,

size_t num_options) {

DummyDelegateOptions options = TfLiteDummyDelegateOptionsDefault();

// Parse key-values options to DummyDelegateOptions.

// You can achieve this by mimicking them as command-line flags.

std::unique_ptr<const char*> argv =

std::unique_ptr<const char*>(new const char*[num_options + 1]);

constexpr char kDummyDelegateParsing[] = "dummy_delegate_parsing";

argv.get()[0] = kDummyDelegateParsing;

std::vector<std::string> option_args;

option_args.reserve(num_options);

for (int i = 0; i < num_options; ++i) {

option_args.emplace_back("--");

option_args.rbegin()->append(options_keys[i]);

option_args.rbegin()->push_back('=');

option_args.rbegin()->append(options_values[i]);

argv.get()[i + 1] = option_args.rbegin()->c_str();

}

// Define command-line flags.

// ...

std::vector<tflite::Flag> flag_list = {

tflite::Flag::CreateFlag(...),

...,

tflite::Flag::CreateFlag(...),

};

int argc = num_options + 1;

if (!tflite::Flags::Parse(&argc, argv.get(), flag_list)) {

return nullptr;

}

return TfLiteDummyDelegateCreate(&options);

}

#ifdef __cplusplus

extern "C" {

#endif // __cplusplus

// Defines two symbols that need to be exported to use the TFLite external

// delegate. See tensorflow/lite/delegates/external for details.

TFL_CAPI_EXPORT TfLiteDelegate* tflite_plugin_create_delegate(

char** options_keys, char** options_values, size_t num_options,

void (*report_error)(const char*)) {

return tflite::tools::CreateDummyDelegateFromOptions(

options_keys, options_values, num_options);

}

TFL_CAPI_EXPORT void tflite_plugin_destroy_delegate(TfLiteDelegate* delegate) {

TfLiteDummyDelegateDelete(delegate);

}

#ifdef __cplusplus

}

#endif // __cplusplus

এখন নীচে দেখানো হিসাবে একটি গতিশীল লাইব্রেরি তৈরি করতে সংশ্লিষ্ট BUILD লক্ষ্য তৈরি করুন:

cc_binary(

name = "dummy_external_delegate.so",

srcs = [

"external_delegate_adaptor.cc",

],

linkshared = 1,

linkstatic = 1,

deps = [

":dummy_delegate",

"//tensorflow/lite/c:common",

"//tensorflow/lite/tools:command_line_flags",

"//tensorflow/lite/tools:logging",

],

)

এই বাহ্যিক প্রতিনিধি .so ফাইলটি তৈরি হওয়ার পরে, আপনি বাইনারি তৈরি করতে পারেন বা নতুন প্রতিনিধির সাথে চালানোর জন্য পূর্ব-নির্মিতগুলি ব্যবহার করতে পারেন যতক্ষণ না বাইনারিটি external_delegate_provider লাইব্রেরির সাথে সংযুক্ত থাকে যা এখানে বর্ণিত কমান্ড-লাইন পতাকা সমর্থন করে। দ্রষ্টব্য: এই বহিরাগত প্রতিনিধি প্রদানকারীকে ইতিমধ্যেই বিদ্যমান টেস্টিং এবং টুলিং বাইনারিগুলির সাথে সংযুক্ত করা হয়েছে৷

এই বাহ্যিক-প্রতিনিধি পদ্ধতির মাধ্যমে কীভাবে ডামি প্রতিনিধিকে বেঞ্চমার্ক করা যায় তার উদাহরণের জন্য এখানে বর্ণনাগুলি পড়ুন। আপনি পূর্বে উল্লিখিত পরীক্ষা এবং মূল্যায়ন সরঞ্জামগুলির জন্য অনুরূপ কমান্ড ব্যবহার করতে পারেন।

এটা লক্ষণীয় যে বহিরাগত প্রতিনিধি হল Tensorflow Lite Python বাইন্ডিং-এ প্রতিনিধির সংশ্লিষ্ট C++ বাস্তবায়ন এখানে দেখানো হয়েছে। তাই, এখানে তৈরি ডায়নামিক এক্সটারনাল ডেলিগেট অ্যাডাপ্টার লাইব্রেরি সরাসরি Tensorflow Lite Python API-এর সাথে ব্যবহার করা যেতে পারে।

সম্পদ

রাতের জন্য পূর্ব-নির্মিত TFLite টুলিং বাইনারিগুলির জন্য লিঙ্কগুলি ডাউনলোড করুন

| ওএস | ARCH | BINARY_NAME |

| লিনাক্স | x86_64 | |

| বাহু | ||

| aarch64 | ||

| অ্যান্ড্রয়েড | বাহু | |

| aarch64 |