このページでは、TensorFlow Lite コンバータを使用して、TensorFlow モデルを TensorFlow Lite モデル (.tflite ファイル拡張子の最適化された FlatBuffer 形式) を変換する方法について説明します。

注意: このガイドでは、インストールされた TensorFlow 2.x と TensorFlow 2.x でトレーニングされたモデルの両方があることを前提とします。TensorFlow 1.x でモデルがトレーニングされる場合、TensorFlow 2.x に移行することを検討してください。インストールされた TensorFlow バージョンを指定するには、print(tf.__version__) を実行します。

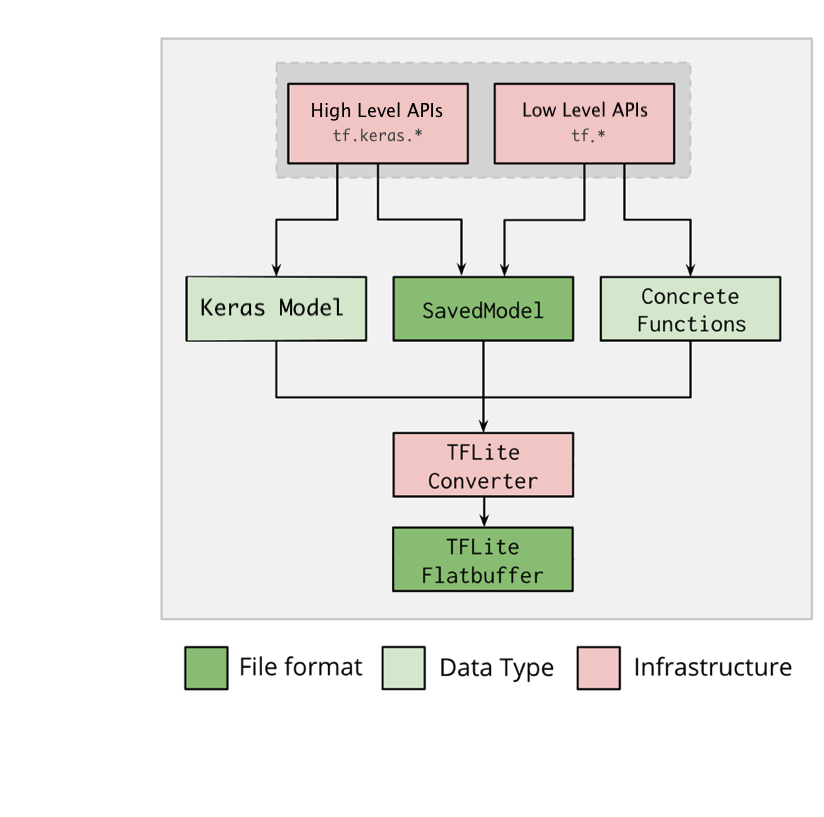

変換ワークフロー

次の図は、モデルを変換するワークフローの概要を示します。

図 1. コンバータワークフロー。

次のオプションのいずれかを使用して、モデルを変換できます。

- Python API (推奨): これにより、変換を開発パイプラインに統合し、最適化を適用して、メタデータや、変換プロセスを簡素化する他の多数のタスクを追加できます。

- コマンドライン: 基本モデル変換のみがサポートされます。

注意: モデル変換中に問題が発生する場合は、GitHub 問題を作成してください。

Python API

ヘルパーコード: TensorFlow Lite converter API の詳細を表示するには、print(help(tf.lite.TFLiteConverter)) を実行します。

tf.lite.TFLiteConverter を使用して、TensorFlow モデルを変換します。TensorFlow モデルは SavedModel 形式で保存され、上位の tf.keras.* API (Keras モデル) または (具象関数を生成する基になる) 下位の tf.* API を使用して生成されます。結果として、次の 3 つオプションを使用できます (例については、次のセクションを参照)。

tf.lite.TFLiteConverter.from_saved_model()(recommended): SavedModel を変換します。tf.lite.TFLiteConverter.from_keras_model(): Keras モデルを変換します。tf.lite.TFLiteConverter.from_concrete_functions(): 具象関数を変換します。

SavedModel の変換 (推奨)

次の例は、SavedModel を TensorFlow Lite モデルに変換する方法を示します。

import tensorflow as tf

# Convert the model

converter = tf.lite.TFLiteConverter.from_saved_model(saved_model_dir) # path to the SavedModel directory

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

Keras モデルの変換

次の例は、Keras モデルを TensorFlow Lite モデルに変換する方法を示します。

import tensorflow as tf

# Create a model using high-level tf.keras.* APIs

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(units=1, input_shape=[1]),

tf.keras.layers.Dense(units=16, activation='relu'),

tf.keras.layers.Dense(units=1)

])

model.compile(optimizer='sgd', loss='mean_squared_error') # compile the model

model.fit(x=[-1, 0, 1], y=[-3, -1, 1], epochs=5) # train the model

# (to generate a SavedModel) tf.saved_model.save(model, "saved_model_keras_dir")

# Convert the model.

converter = tf.lite.TFLiteConverter.from_keras_model(model)

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

具象関数の変換

次の例は、具象関数を TensorFlow Lite モデルに変換する方法を示します。

import tensorflow as tf

# Create a model using low-level tf.* APIs

class Squared(tf.Module):

@tf.function(input_signature=[tf.TensorSpec(shape=[None], dtype=tf.float32)])

def __call__(self, x):

return tf.square(x)

model = Squared()

# (ro run your model) result = Squared(5.0) # This prints "25.0"

# (to generate a SavedModel) tf.saved_model.save(model, "saved_model_tf_dir")

concrete_func = model.__call__.get_concrete_function()

# Convert the model.

converter = tf.lite.TFLiteConverter.from_concrete_functions([concrete_func],

model)

tflite_model = converter.convert()

# Save the model.

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

その他の特徴

最適化を適用します。使用される一般的な最適化は、トレーニング後の量子化です。これにより、精度の損失を最小限に抑えながら、モデルの遅延とサイズを減らすことができます。

メタデータを追加します。これにより、モデルをデバイスにデプロイするときに、プラットフォーム固有のラッパーコードを簡単に作成できます。

変換エラー

次に、一般的な変換エラーと解決策を示します。

エラー:

Some ops are not supported by the native TFLite runtime, you can enable TF kernels fallback using TF Select. See instructions: <a href="https://www.tensorflow.org/lite/guide/ops_select">https://www.tensorflow.org/lite/guide/ops_select</a> TF Select ops: ..., .., ...解決策: このエラーは、対応する TFLite 実装のない TF がモデルに存在するときに発生します。この問題を解決するには、TFLite モデルで TF 演算を使用します (推奨)。TFLite 演算のみのモデルを生成する場合は、Github 問題 #21526 で不足している TFLite 演算の要求を追加する (要求がメンションされていない場合はコメントを残す) か、自分で TFLite 演算を作成します。

エラー:

.. is neither a custom op nor a flex op解決策: この TF 演算のサポート状況によって異なります。

TF でサポート: 許可リスト (TFLite でサポートされる TF 演算の網羅的なリスト) に TF 処理がないため、このエラーが発生します。次の方法で解決できます。

TF でサポートされていない: TFLite が定義されたカスタム TF 演算を認識していないため、このエラーが発生します。次の方法で解決できます。

- TF 演算を作成する。

- TF モデルを TFLite モデルに変換する。

- TFLite 演算を作成し、TFLite ランタイムに関連付けて推論を実行する。

コマンドラインツール

注意: 可能なかぎり、上記の Python API を使用することを強くお勧めします。

pip から TensorFlow 2.x をインストールした場合は、tflite_convert コマンドを使用します。使用可能なフラグをすべて表示するには、次のコマンドを使用します。

$ tflite_convert --help

`--output_file`. Type: string. Full path of the output file.

`--saved_model_dir`. Type: string. Full path to the SavedModel directory.

`--keras_model_file`. Type: string. Full path to the Keras H5 model file.

`--enable_v1_converter`. Type: bool. (default False) Enables the converter and flags used in TF 1.x instead of TF 2.x.

You are required to provide the `--output_file` flag and either the `--saved_model_dir` or `--keras_model_file` flag.

TensorFlow 2.x ソースをダウンロードし、パッケージを構築してインストールせずに、そのソースからコンバータを実行する場合は、コマンドの 'tflite_convert' を 'bazel run tensorflow/lite/python:tflite_convert --' で置き換えます。

SavedModel の変換

tflite_convert \

--saved_model_dir=/tmp/mobilenet_saved_model \

--output_file=/tmp/mobilenet.tflite

Keras H5 モデルの変換

tflite_convert \

--keras_model_file=/tmp/mobilenet_keras_model.h5 \

--output_file=/tmp/mobilenet.tflite

次のステップ

TensorFlow Lite インタープリタ を使用して、クライアントデバイス (例: モバイル、組み込み) で推論を実行します。