Детекторы объектов могут определить, какие из известных объектов могут присутствовать, и предоставить информацию об их положении в данном изображении или видеопотоке. Детектор объектов обучен обнаруживать присутствие и местоположение объектов нескольких классов. Например, модель может быть обучена с использованием изображений, содержащих различные кусочки фруктов, а также метки , указывающей класс фруктов, которые они представляют (например, яблоко, банан или клубника), и данных, определяющих, где каждый объект появляется в Изображение. Дополнительную информацию о детекторах объектов см. в разделе «Введение в обнаружение объектов ».

Используйте API ObjectDetector библиотеки задач для развертывания собственных или предварительно обученных детекторов объектов в мобильных приложениях.

Ключевые особенности API ObjectDetector

Обработка входного изображения, включая вращение, изменение размера и преобразование цветового пространства.

Метка локали карты.

Порог оценки для фильтрации результатов.

Результаты обнаружения Top-k.

Пометьте список разрешенных и список запрещенных.

Поддерживаемые модели детекторов объектов

Следующие модели гарантированно совместимы с API ObjectDetector .

Предварительно обученные модели обнаружения объектов на TensorFlow Hub .

Модели, созданные с помощью AutoML Vision Edge Object Detection .

Модели, созданные TensorFlow Lite Model Maker для детектора объектов .

Пользовательские модели, соответствующие требованиям совместимости моделей .

Запустить вывод в Java

См. справочное приложение «Обнаружение объектов» , где приведен пример использования ObjectDetector в приложении для Android.

Шаг 1. Импортируйте зависимости Gradle и другие настройки.

Скопируйте файл модели .tflite в каталог ресурсов модуля Android, где будет запускаться модель. Укажите, что файл не должен быть сжат, и добавьте библиотеку TensorFlow Lite в файл build.gradle модуля:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency (NNAPI is included)

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

Шаг 2: Использование модели

// Initialization

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setMaxResults(1)

.build();

ObjectDetector objectDetector =

ObjectDetector.createFromFileAndOptions(

context, modelFile, options);

// Run inference

List<Detection> results = objectDetector.detect(image);

Дополнительные параметры настройки ObjectDetector см. в исходном коде и документации Javadoc .

Запустить вывод в iOS

Шаг 1. Установите зависимости

Библиотека задач поддерживает установку с использованием CocoaPods. Убедитесь, что CocoaPods установлен в вашей системе. Инструкции см. в руководстве по установке CocoaPods .

Подробную информацию о добавлении модулей в проект Xcode см. в руководстве CocoaPods .

Добавьте модуль TensorFlowLiteTaskVision в Podfile.

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

Убедитесь, что модель .tflite , которую вы будете использовать для вывода, присутствует в вашем пакете приложений.

Шаг 2: Использование модели

Быстрый

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "ssd_mobilenet_v1",

ofType: "tflite") else { return }

let options = ObjectDetectorOptions(modelPath: modelPath)

// Configure any additional options:

// options.classificationOptions.maxResults = 3

let detector = try ObjectDetector.detector(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "cats_and_dogs.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let detectionResult = try detector.detect(mlImage: mlImage)

Цель С

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"ssd_mobilenet_v1" ofType:@"tflite"];

TFLObjectDetectorOptions *options = [[TFLObjectDetectorOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.classificationOptions.maxResults = 3;

TFLObjectDetector *detector = [TFLObjectDetector objectDetectorWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"dogs.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLDetectionResult *detectionResult = [detector detectWithGMLImage:gmlImage error:nil];

Дополнительные параметры настройки TFLObjectDetector см. в исходном коде .

Запустить вывод в Python

Шаг 1. Установите пакет pip

pip install tflite-support

Шаг 2: Использование модели

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

detection_options = processor.DetectionOptions(max_results=2)

options = vision.ObjectDetectorOptions(base_options=base_options, detection_options=detection_options)

detector = vision.ObjectDetector.create_from_options(options)

# Alternatively, you can create an object detector in the following manner:

# detector = vision.ObjectDetector.create_from_file(model_path)

# Run inference

image = vision.TensorImage.create_from_file(image_path)

detection_result = detector.detect(image)

Дополнительные параметры настройки ObjectDetector см. в исходном коде .

Запустить вывод на C++

// Initialization

ObjectDetectorOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ObjectDetector> object_detector = ObjectDetector::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const DetectionResult result = object_detector->Detect(*frame_buffer).value();

Дополнительные параметры настройки ObjectDetector см. в исходном коде .

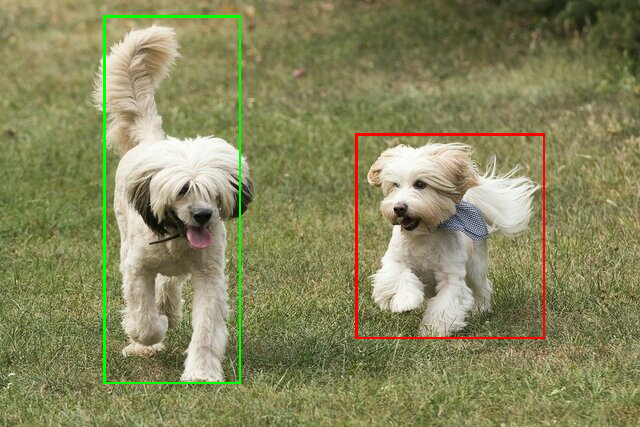

Примеры результатов

Вот пример результатов обнаружения ssd mobilenet v1 из TensorFlow Hub.

Results:

Detection #0 (red):

Box: (x: 355, y: 133, w: 190, h: 206)

Top-1 class:

index : 17

score : 0.73828

class name : dog

Detection #1 (green):

Box: (x: 103, y: 15, w: 138, h: 369)

Top-1 class:

index : 17

score : 0.73047

class name : dog

Отобразите ограничивающие рамки на входном изображении:

Попробуйте простой демонстрационный инструмент CLI для ObjectDetector с вашей собственной моделью и тестовыми данными.

Требования совместимости модели

API ObjectDetector ожидает модель TFLite с обязательными метаданными модели TFLite . См. примеры создания метаданных для детекторов объектов с помощью API TensorFlow Lite Metadata Writer .

Совместимые модели детекторов объектов должны соответствовать следующим требованиям:

Тензор входного изображения: (kTfLiteUInt8/kTfLiteFloat32)

- Ввод изображения размера

[batch x height x width x channels]. - Пакетный вывод не поддерживается (

batchдолжен быть равен 1). - поддерживаются только входы RGB (

channelsдолжно быть 3). - если тип — kTfLiteFloat32, параметры NormalizationOptions необходимо прикрепить к метаданным для нормализации ввода.

- Ввод изображения размера

Выходные тензоры должны быть четырьмя выходами операции

DetectionPostProcess, т.е.:- Тензор локаций (kTfLiteFloat32)

- тензор размера

[1 x num_results x 4], внутренний массив, представляющий ограничивающие рамки в форме [сверху, слева, справа, снизу]. - BoundingBoxProperties должны быть прикреплены к метаданным и должны указывать

type=BOUNDARIESи `coordinate_type=RATIO.

- тензор размера

Тензор классов (kTfLiteFloat32)

- тензор размера

[1 x num_results], каждое значение представляет собой целочисленный индекс класса. - необязательные (но рекомендуемые) карты меток могут быть прикреплены как AssociatedFile-s с типом TENSOR_VALUE_LABELS, содержащими одну метку в строке. См. пример файла этикетки . Первый такой AssociatedFile (если есть) используется для заполнения поля

class_nameрезультатов. Полеdisplay_nameзаполняется из AssociatedFile (если есть), языковой стандарт которого соответствует полюdisplay_names_localeObjectDetectorOptions, используемому во время создания («en» по умолчанию, т.е. английский). Если ни один из них недоступен, будет заполнено только полеindexрезультатов.

- тензор размера

Тензор оценок (kTfLiteFloat32)

- тензор размера

[1 x num_results], каждое значение представляет оценку обнаруженного объекта.

- тензор размера

Тензор количества обнаружения (kTfLiteFloat32)

- целое число num_results как тензор размера

[1].

- целое число num_results как тензор размера

- Тензор локаций (kTfLiteFloat32)