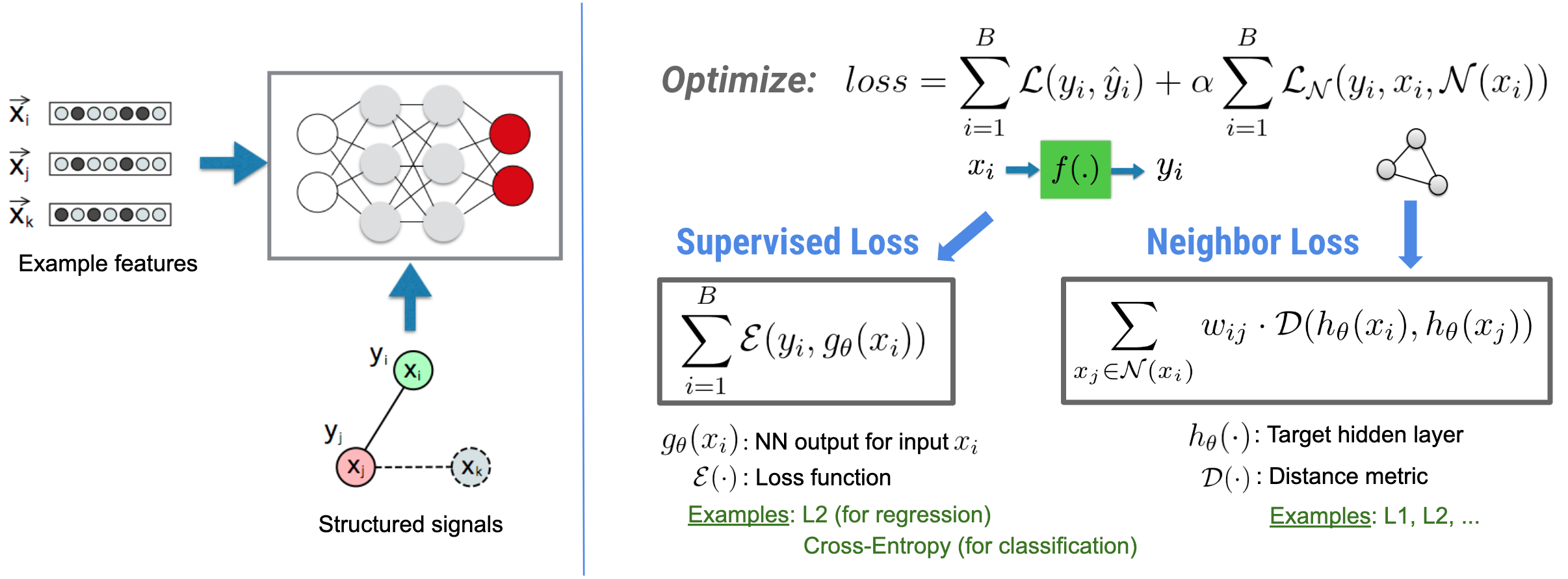

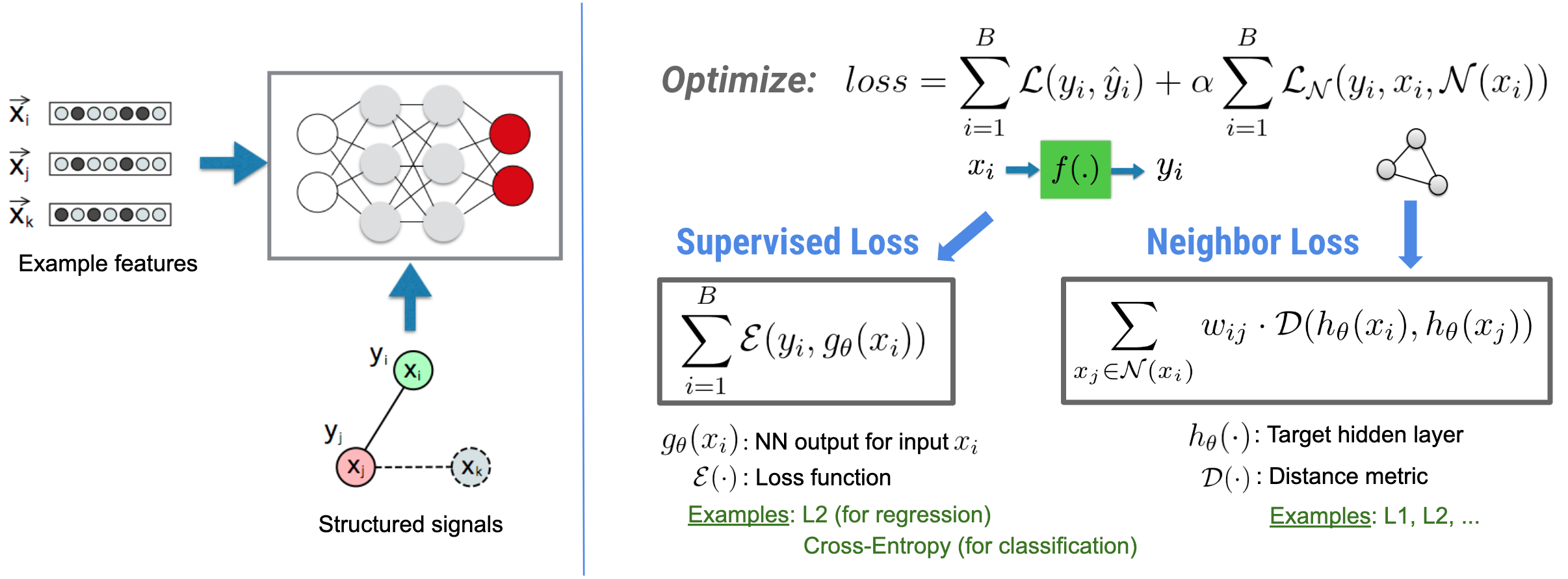

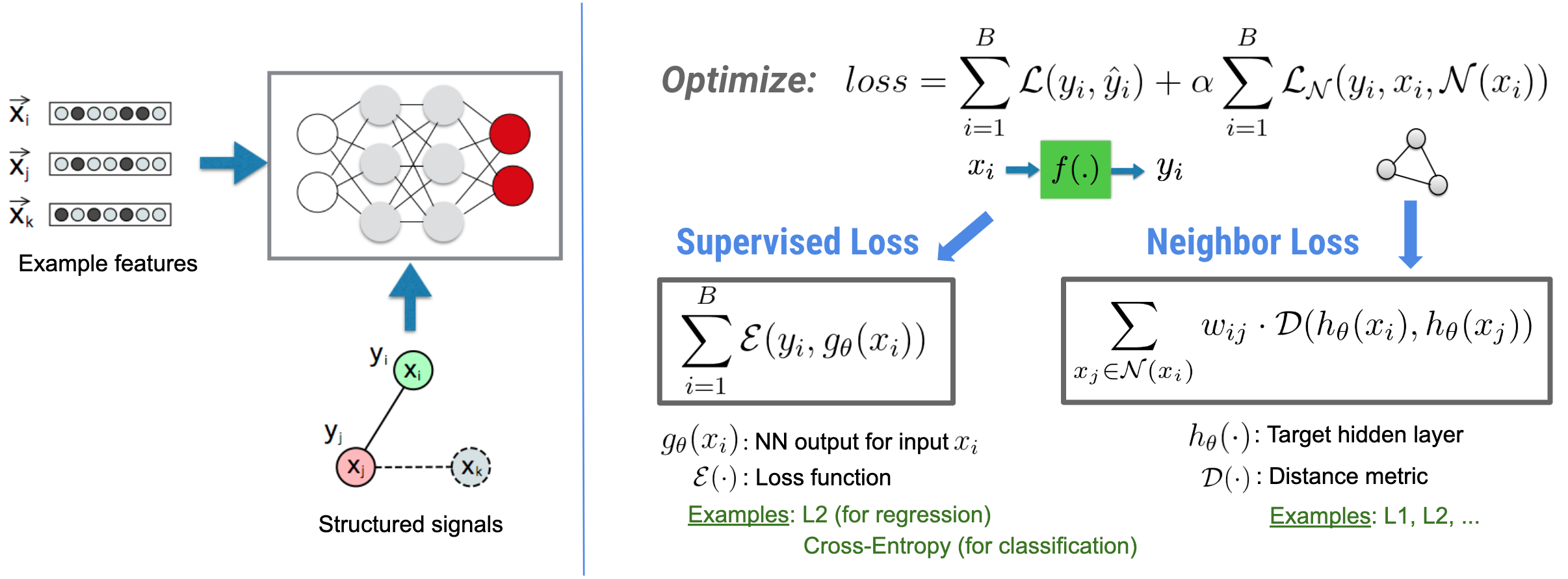

Sinirsel Yapılandırılmış Öğrenme (NSL), özellik girişleriyle birlikte yapılandırılmış sinyallerden (mevcut olduğunda) yararlanarak derin sinir ağlarının eğitilmesine odaklanır. Bui ve ark. (WSDM'18) uyarınca , bu yapılandırılmış sinyaller bir sinir ağının eğitimini düzenlemek için kullanılır, modeli doğru tahminler öğrenmeye zorlar (denetlenen kaybı en aza indirerek) ve aynı zamanda girdi yapısal benzerliğini korur (komşu kaybını en aza indirerek) , aşağıdaki şekle bakın). Bu teknik geneldir ve isteğe bağlı sinir mimarilerine (ileri beslemeli YSA'lar, Evrişimli YSA'lar ve Tekrarlayan YSA'lar gibi) uygulanabilir.

Genelleştirilmiş komşu kaybı denkleminin esnek olduğunu ve yukarıda gösterilenin dışında başka formlara da sahip olabileceğini unutmayın. Örneğin şunu da seçebiliriz:\(\sum_{x_j \in \mathcal{N}(x_i)}\mathcal{E}(y_i,g_\theta(x_j))\) temel gerçek arasındaki mesafeyi hesaplayan komşu kaybı olacaktır. \(y_i\)ve komşunun tahmini \(g_\theta(x_j)\). Bu, çekişmeli öğrenmede yaygın olarak kullanılır (Goodfellow ve diğerleri, ICLR'15) . Bu nedenle NSL, eğer komşular açıkça bir grafikle temsil ediliyorsa Nöral Grafik Öğrenimini ve eğer komşular örtülü olarak çekişmeli tedirginlik tarafından tetikleniyorsa Çekişmeli Öğrenmeyi genelleştirir.

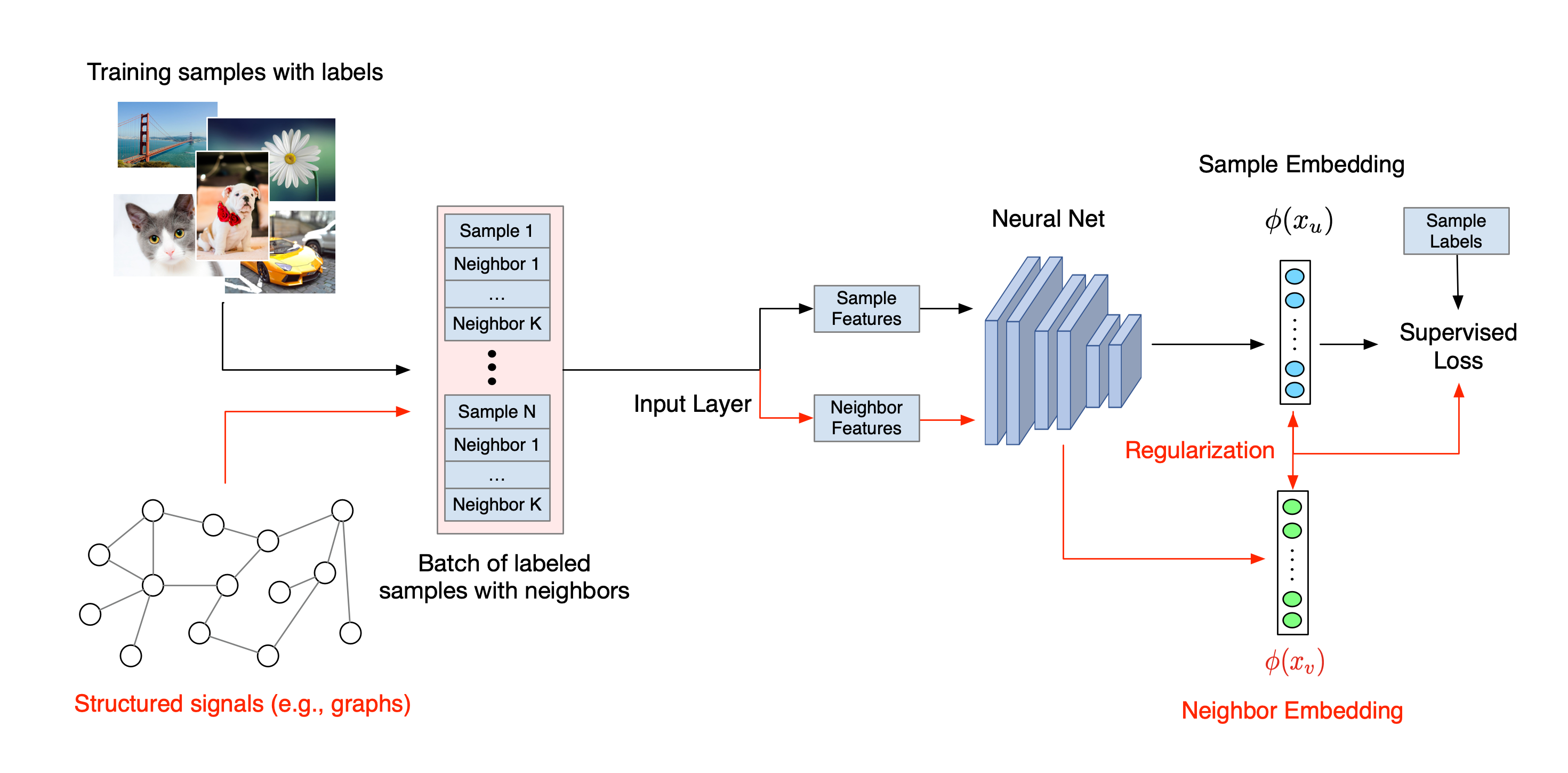

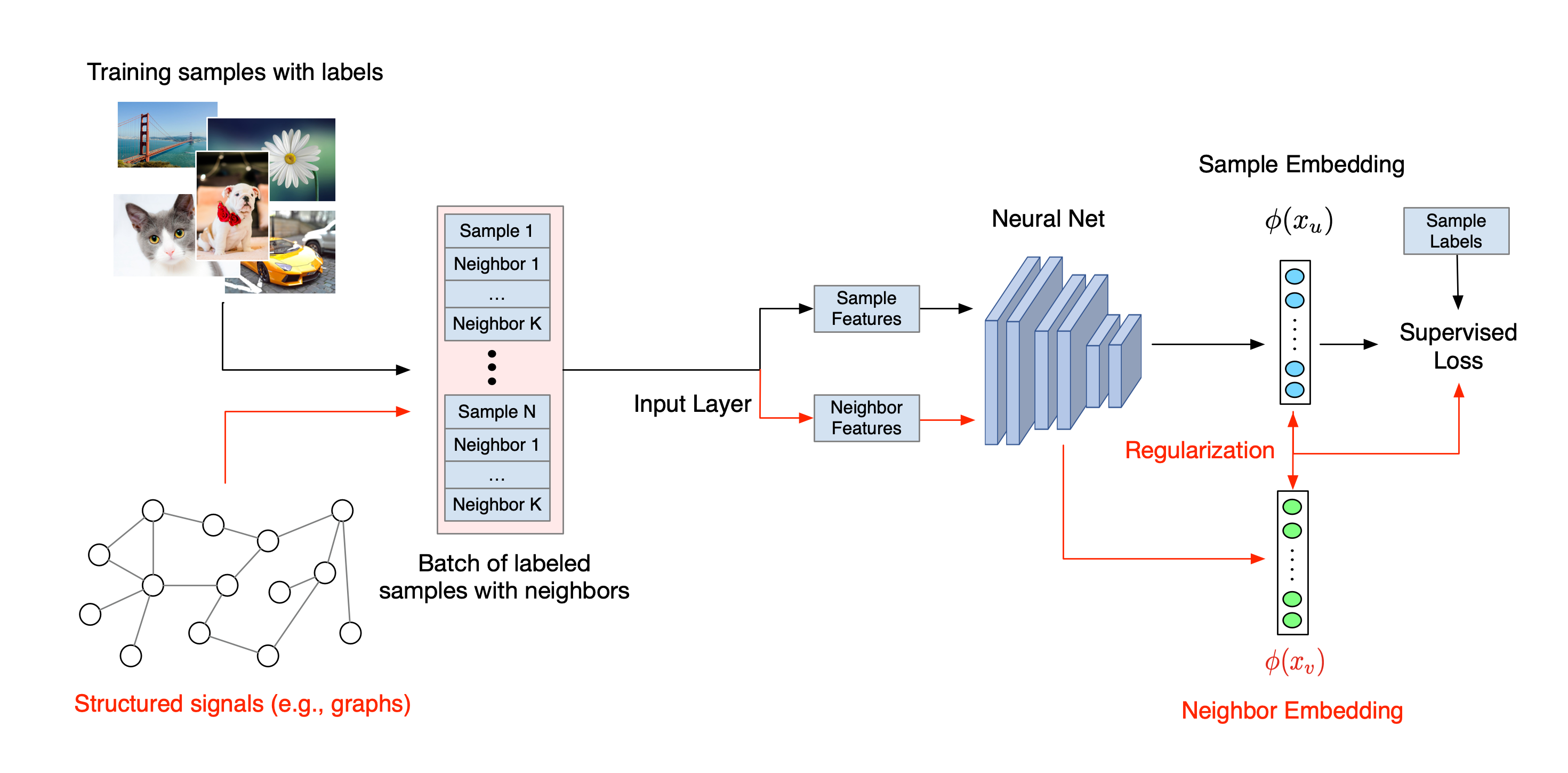

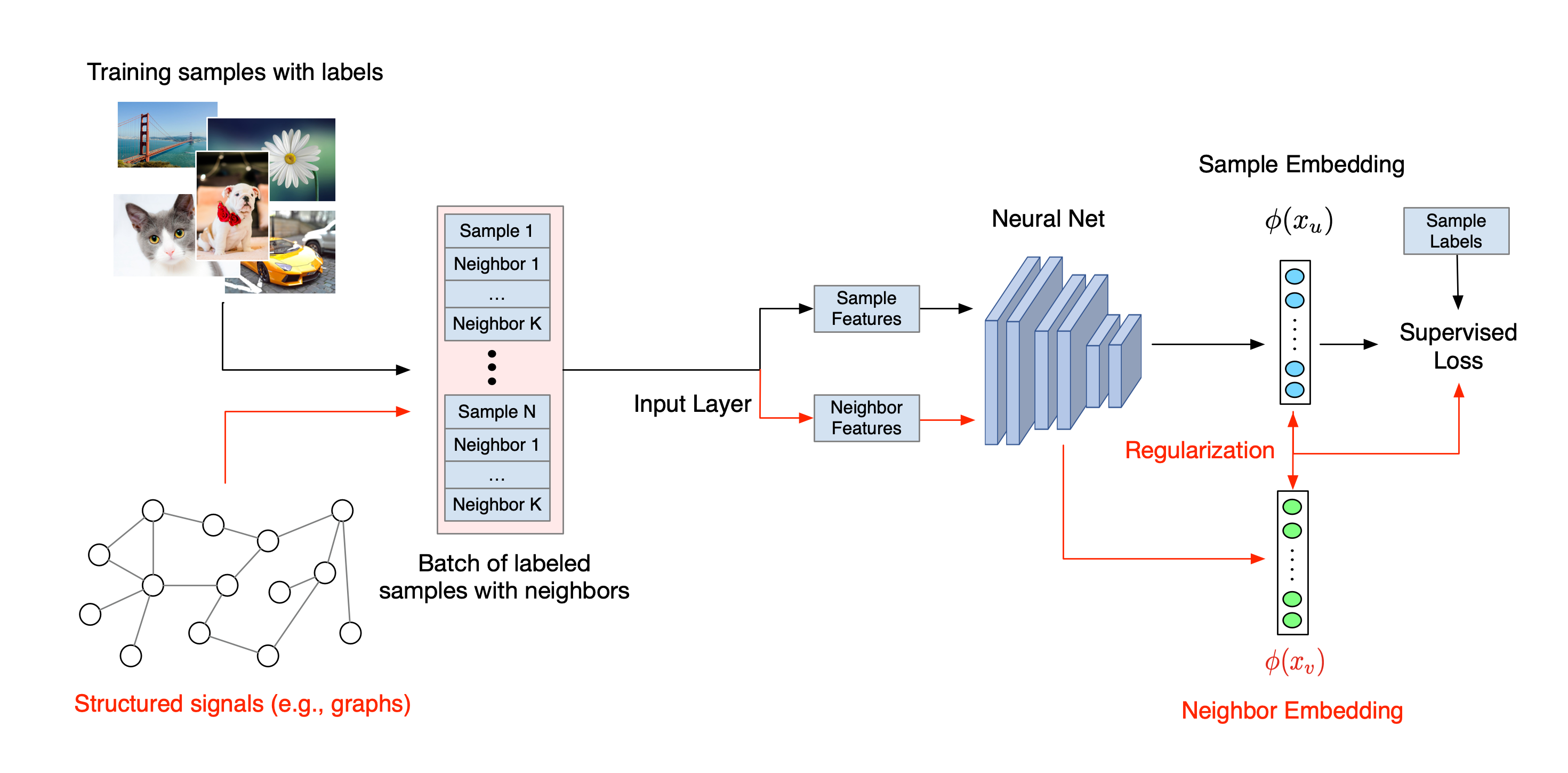

Sinirsel Yapılandırılmış Öğrenmenin genel iş akışı aşağıda gösterilmektedir. Siyah oklar geleneksel eğitim iş akışını temsil eder ve kırmızı oklar, NSL tarafından yapılandırılmış sinyallerden yararlanmak için sunulan yeni iş akışını temsil eder. İlk olarak, eğitim örnekleri yapılandırılmış sinyalleri içerecek şekilde genişletilir. Yapılandırılmış sinyaller açıkça sağlanmadığında, bunlar ya oluşturulabilir ya da tetiklenebilir (ikincisi çekişmeli öğrenme için geçerlidir). Daha sonra, artırılmış eğitim örnekleri (hem orijinal örnekler hem de bunlara karşılık gelen komşuları dahil), yerleştirmelerinin hesaplanması için sinir ağına beslenir. Bir numunenin gömülmesi ile komşusunun gömülmesi arasındaki mesafe hesaplanır ve komşu kaybı olarak kullanılır; bu, bir düzenleme terimi olarak ele alınır ve nihai kayba eklenir. Açık komşu bazlı düzenleme için, genellikle komşu kaybını, örneğin gömülmesi ile komşunun gömülmesi arasındaki mesafe olarak hesaplarız. Ancak sinir ağının herhangi bir katmanı komşu kaybını hesaplamak için kullanılabilir. Öte yandan, uyarılmış komşu tabanlı düzenleme (düşman) için, komşu kaybını, uyarılmış rakip komşunun çıktı tahmini ile temel doğruluk etiketi arasındaki mesafe olarak hesaplıyoruz.

NSL'yi neden kullanmalısınız?

NSL aşağıdaki avantajları sağlar:

- Daha yüksek doğruluk : Örnekler arasındaki yapılandırılmış sinyal(ler), özellik girişlerinde her zaman mevcut olmayan bilgileri sağlayabilir; bu nedenle, ortak eğitim yaklaşımının (hem yapılandırılmış sinyaller hem de özelliklerle birlikte), belge sınıflandırması ve anlamsal amaç sınıflandırması gibi çok çeşitli görevlerde (yalnızca özelliklerle eğitime dayanan) mevcut birçok yöntemden daha iyi performans gösterdiği gösterilmiştir ( Bui ve ark. ., WSDM'18 ve Kipf ve diğerleri, ICLR'17 ).

- Sağlamlık : Karşıt örneklerle eğitilmiş modellerin, bir modelin tahminini veya sınıflandırmasını yanıltmak için tasarlanmış olumsuz tedirginliklere karşı dayanıklı olduğu gösterilmiştir ( Goodfellow ve diğerleri, ICLR'15 & Miyato ve diğerleri, ICLR'16 ). Eğitim örneklerinin sayısı az olduğunda, rakip örneklerle eğitim aynı zamanda model doğruluğunun geliştirilmesine de yardımcı olur ( Tsipras ve diğerleri, ICLR'19 ).

- Daha az etiketli veri gerekli : NSL, sinir ağlarının hem etiketli hem de etiketsiz verilerden yararlanmasını sağlar, bu da öğrenme paradigmasını yarı denetimli öğrenmeye kadar genişletir. Spesifik olarak NSL, ağın denetlenen ortamda olduğu gibi etiketli verileri kullanarak eğitim almasına olanak tanır ve aynı zamanda ağı, etiketlere sahip olan veya olmayan "komşu örnekler" için benzer gizli gösterimleri öğrenmeye yönlendirir. Bu teknik, etiketli veri miktarı nispeten küçük olduğunda model doğruluğunun iyileştirilmesi konusunda büyük umut vaat etmektedir ( Bui ve diğerleri, WSDM'18 & Miyato ve diğerleri, ICLR'16 ).

Adım Adım Öğreticiler

Sinirsel Yapılandırılmış Öğrenme konusunda uygulamalı deneyim elde etmek için, yapılandırılmış sinyallerin açıkça verilebildiği, oluşturulabildiği veya tetiklenebildiği çeşitli senaryoları kapsayan eğitimlerimiz bulunmaktadır. İşte birkaçı:

Doğal grafikleri kullanarak belge sınıflandırması için grafik düzenlemesi . Bu derste, doğal (organik) bir grafik oluşturan belgeleri sınıflandırmak için grafik düzenlemenin kullanımını araştırıyoruz.

Sentezlenmiş grafikler kullanılarak duyarlılık sınıflandırması için grafik düzenlemesi . Bu öğreticide, yapılandırılmış sinyaller oluşturarak (sentezleyerek) film incelemesi görüşlerini sınıflandırmak için grafik düzenlemenin kullanımını gösteriyoruz.

Görüntü sınıflandırması için çekişmeli öğrenme . Bu derste, sayısal basamaklar içeren görüntüleri sınıflandırmak için çekişmeli öğrenmenin (yapılandırılmış sinyallerin tetiklendiği yerde) kullanımını araştırıyoruz.

Daha fazla örnek ve öğreticiyi GitHub depomuzun örnekler dizininde bulabilirsiniz.

,Sinirsel Yapılandırılmış Öğrenme (NSL), özellik girişleriyle birlikte yapılandırılmış sinyallerden (mevcut olduğunda) yararlanarak derin sinir ağlarının eğitilmesine odaklanır. Bui ve ark. (WSDM'18) uyarınca , bu yapılandırılmış sinyaller bir sinir ağının eğitimini düzenlemek için kullanılır, modeli doğru tahminler öğrenmeye zorlar (denetlenen kaybı en aza indirerek) ve aynı zamanda girdi yapısal benzerliğini korur (komşu kaybını en aza indirerek) , aşağıdaki şekle bakın). Bu teknik geneldir ve isteğe bağlı sinir mimarilerine (ileri beslemeli NN'ler, Evrişimli NN'ler ve Tekrarlayan NN'ler gibi) uygulanabilir.

Genelleştirilmiş komşu kaybı denkleminin esnek olduğunu ve yukarıda gösterilenin dışında başka formlara da sahip olabileceğini unutmayın. Örneğin şunu da seçebiliriz:\(\sum_{x_j \in \mathcal{N}(x_i)}\mathcal{E}(y_i,g_\theta(x_j))\) temel gerçek arasındaki mesafeyi hesaplayan komşu kaybı olacaktır. \(y_i\)ve komşunun tahmini \(g_\theta(x_j)\). Bu, çekişmeli öğrenmede yaygın olarak kullanılır (Goodfellow ve diğerleri, ICLR'15) . Bu nedenle NSL, eğer komşular açıkça bir grafikle temsil ediliyorsa Nöral Grafik Öğrenimini ve eğer komşular örtülü olarak çekişmeli tedirginlik tarafından tetikleniyorsa Çekişmeli Öğrenmeyi genelleştirir.

Sinirsel Yapılandırılmış Öğrenmenin genel iş akışı aşağıda gösterilmektedir. Siyah oklar geleneksel eğitim iş akışını temsil eder ve kırmızı oklar, NSL tarafından yapılandırılmış sinyallerden yararlanmak için sunulan yeni iş akışını temsil eder. İlk olarak, eğitim örnekleri yapılandırılmış sinyalleri içerecek şekilde genişletilir. Yapılandırılmış sinyaller açıkça sağlanmadığında, bunlar ya oluşturulabilir ya da tetiklenebilir (ikincisi çekişmeli öğrenme için geçerlidir). Daha sonra, artırılmış eğitim örnekleri (hem orijinal örnekler hem de bunlara karşılık gelen komşuları dahil), yerleştirmelerinin hesaplanması için sinir ağına beslenir. Bir numunenin gömülmesi ile komşusunun gömülmesi arasındaki mesafe hesaplanır ve komşu kaybı olarak kullanılır; bu, bir düzenleme terimi olarak ele alınır ve nihai kayba eklenir. Açık komşu bazlı düzenleme için, genellikle komşu kaybını, örneğin gömülmesi ile komşunun gömülmesi arasındaki mesafe olarak hesaplarız. Ancak sinir ağının herhangi bir katmanı komşu kaybını hesaplamak için kullanılabilir. Öte yandan, uyarılmış komşu tabanlı düzenleme (düşman) için, komşu kaybını, uyarılmış rakip komşunun çıktı tahmini ile temel doğruluk etiketi arasındaki mesafe olarak hesaplıyoruz.

NSL'yi neden kullanmalısınız?

NSL aşağıdaki avantajları sağlar:

- Daha yüksek doğruluk : Örnekler arasındaki yapılandırılmış sinyal(ler), özellik girişlerinde her zaman mevcut olmayan bilgileri sağlayabilir; bu nedenle, ortak eğitim yaklaşımının (hem yapılandırılmış sinyaller hem de özelliklerle birlikte), belge sınıflandırması ve anlamsal amaç sınıflandırması gibi çok çeşitli görevlerde (yalnızca özelliklerle eğitime dayanan) mevcut birçok yöntemden daha iyi performans gösterdiği gösterilmiştir ( Bui ve ark. ., WSDM'18 ve Kipf ve arkadaşları, ICLR'17 ).

- Sağlamlık : Karşıt örneklerle eğitilmiş modellerin, bir modelin tahminini veya sınıflandırmasını yanıltmak için tasarlanmış olumsuz tedirginliklere karşı dayanıklı olduğu gösterilmiştir ( Goodfellow ve diğerleri, ICLR'15 & Miyato ve diğerleri, ICLR'16 ). Eğitim örneklerinin sayısı az olduğunda, rakip örneklerle eğitim de model doğruluğunun geliştirilmesine yardımcı olur ( Tsipras ve diğerleri, ICLR'19 ).

- Daha az etiketli veri gerekli : NSL, sinir ağlarının hem etiketli hem de etiketsiz verilerden yararlanmasını sağlar, bu da öğrenme paradigmasını yarı denetimli öğrenmeye kadar genişletir. Spesifik olarak NSL, ağın denetlenen ortamda olduğu gibi etiketli verileri kullanarak eğitim almasına olanak tanır ve aynı zamanda ağı, etiketlere sahip olan veya olmayan "komşu örnekler" için benzer gizli gösterimleri öğrenmeye yönlendirir. Bu teknik, etiketli veri miktarı nispeten küçük olduğunda model doğruluğunun iyileştirilmesi konusunda büyük umut vaat etmektedir ( Bui ve diğerleri, WSDM'18 & Miyato ve diğerleri, ICLR'16 ).

Adım Adım Öğreticiler

Sinirsel Yapılandırılmış Öğrenme konusunda uygulamalı deneyim elde etmek için, yapılandırılmış sinyallerin açıkça verilebildiği, oluşturulabildiği veya tetiklenebildiği çeşitli senaryoları kapsayan eğitimlerimiz bulunmaktadır. İşte birkaçı:

Doğal grafikleri kullanarak belge sınıflandırması için grafik düzenlemesi . Bu derste, doğal (organik) bir grafik oluşturan belgeleri sınıflandırmak için grafik düzenlemenin kullanımını araştırıyoruz.

Sentezlenmiş grafikler kullanılarak duyarlılık sınıflandırması için grafik düzenlemesi . Bu öğreticide, yapılandırılmış sinyaller oluşturarak (sentezleyerek) film incelemesi görüşlerini sınıflandırmak için grafik düzenlemenin kullanımını gösteriyoruz.

Görüntü sınıflandırması için çekişmeli öğrenme . Bu derste, sayısal basamaklar içeren görüntüleri sınıflandırmak için çekişmeli öğrenmenin (yapılandırılmış sinyallerin tetiklendiği yerde) kullanımını araştırıyoruz.

Daha fazla örnek ve öğreticiyi GitHub depomuzun örnekler dizininde bulabilirsiniz.

,Sinirsel Yapılandırılmış Öğrenme (NSL), özellik girişleriyle birlikte yapılandırılmış sinyallerden (mevcut olduğunda) yararlanarak derin sinir ağlarının eğitilmesine odaklanır. Bui ve ark. (WSDM'18) uyarınca , bu yapılandırılmış sinyaller bir sinir ağının eğitimini düzenlemek için kullanılır, modeli doğru tahminler öğrenmeye zorlar (denetlenen kaybı en aza indirerek) ve aynı zamanda girdi yapısal benzerliğini korur (komşu kaybını en aza indirerek) , aşağıdaki şekle bakın). Bu teknik geneldir ve isteğe bağlı sinir mimarilerine (ileri beslemeli YSA'lar, Evrişimli YSA'lar ve Tekrarlayan YSA'lar gibi) uygulanabilir.

Genelleştirilmiş komşu kaybı denkleminin esnek olduğunu ve yukarıda gösterilenin dışında başka formlara da sahip olabileceğini unutmayın. Örneğin, şunu da seçebiliriz:\(\sum_{x_j \in \mathcal{N}(x_i)}\mathcal{E}(y_i,g_\theta(x_j))\) temel gerçek arasındaki mesafeyi hesaplayan komşu kaybı olacaktır. \(y_i\)ve komşunun tahmini \(g_\theta(x_j)\). Bu, çekişmeli öğrenmede yaygın olarak kullanılır (Goodfellow ve diğerleri, ICLR'15) . Bu nedenle NSL, eğer komşular açıkça bir grafikle temsil ediliyorsa Nöral Grafik Öğrenimini ve eğer komşular örtülü olarak çekişmeli tedirginlik tarafından tetikleniyorsa Çekişmeli Öğrenmeyi genelleştirir.

Sinirsel Yapılandırılmış Öğrenmenin genel iş akışı aşağıda gösterilmiştir. Siyah oklar geleneksel eğitim iş akışını temsil eder ve kırmızı oklar, NSL tarafından yapılandırılmış sinyallerden yararlanmak için sunulan yeni iş akışını temsil eder. İlk olarak, eğitim örnekleri yapılandırılmış sinyalleri içerecek şekilde genişletilir. Yapılandırılmış sinyaller açıkça sağlanmadığında, bunlar ya oluşturulabilir ya da tetiklenebilir (ikincisi çekişmeli öğrenme için geçerlidir). Daha sonra, artırılmış eğitim örnekleri (hem orijinal örnekler hem de bunlara karşılık gelen komşuları dahil), yerleştirmelerinin hesaplanması için sinir ağına beslenir. Bir numunenin gömülmesi ile komşusunun gömülmesi arasındaki mesafe hesaplanır ve komşu kaybı olarak kullanılır; bu, bir düzenleme terimi olarak ele alınır ve nihai kayba eklenir. Açık komşu bazlı düzenleme için, genellikle komşu kaybını, örneğin gömülmesi ile komşunun gömülmesi arasındaki mesafe olarak hesaplarız. Ancak sinir ağının herhangi bir katmanı komşu kaybını hesaplamak için kullanılabilir. Öte yandan, uyarılmış komşu tabanlı düzenleme (düşman) için, komşu kaybını, uyarılmış rakip komşunun çıktı tahmini ile temel doğruluk etiketi arasındaki mesafe olarak hesaplıyoruz.

NSL'yi neden kullanmalısınız?

NSL aşağıdaki avantajları sağlar:

- Daha yüksek doğruluk : Örnekler arasındaki yapılandırılmış sinyal(ler), özellik girişlerinde her zaman mevcut olmayan bilgileri sağlayabilir; bu nedenle, ortak eğitim yaklaşımının (hem yapılandırılmış sinyaller hem de özelliklerle birlikte), belge sınıflandırması ve anlamsal amaç sınıflandırması gibi çok çeşitli görevlerde (yalnızca özelliklerle eğitime dayanan) mevcut birçok yöntemden daha iyi performans gösterdiği gösterilmiştir ( Bui ve ark. ., WSDM'18 ve Kipf ve diğerleri, ICLR'17 ).

- Sağlamlık : Karşıt örneklerle eğitilmiş modellerin, bir modelin tahminini veya sınıflandırmasını yanıltmak için tasarlanmış olumsuz tedirginliklere karşı dayanıklı olduğu gösterilmiştir ( Goodfellow ve diğerleri, ICLR'15 & Miyato ve diğerleri, ICLR'16 ). Eğitim örneklerinin sayısı az olduğunda, rakip örneklerle eğitim de model doğruluğunun geliştirilmesine yardımcı olur ( Tsipras ve diğerleri, ICLR'19 ).

- Daha az etiketli veri gerekli : NSL, sinir ağlarının hem etiketli hem de etiketsiz verilerden yararlanmasını sağlar, bu da öğrenme paradigmasını yarı denetimli öğrenmeye kadar genişletir. Spesifik olarak NSL, ağın denetlenen ortamda olduğu gibi etiketli verileri kullanarak eğitim almasına olanak tanır ve aynı zamanda ağı, etiketlere sahip olan veya olmayan "komşu örnekler" için benzer gizli gösterimleri öğrenmeye yönlendirir. Bu teknik, etiketli veri miktarı nispeten küçük olduğunda model doğruluğunun iyileştirilmesi konusunda büyük umut vaat etmektedir ( Bui ve diğerleri, WSDM'18 & Miyato ve diğerleri, ICLR'16 ).

Adım Adım Öğreticiler

Sinirsel Yapılandırılmış Öğrenme konusunda uygulamalı deneyim elde etmek için, yapılandırılmış sinyallerin açıkça verilebildiği, oluşturulabildiği veya tetiklenebildiği çeşitli senaryoları kapsayan eğitimlerimiz bulunmaktadır. İşte birkaçı:

Doğal grafikleri kullanarak belge sınıflandırması için grafik düzenlemesi . Bu derste, doğal (organik) bir grafik oluşturan belgeleri sınıflandırmak için grafik düzenlemenin kullanımını araştırıyoruz.

Sentezlenmiş grafikler kullanılarak duyarlılık sınıflandırması için grafik düzenlemesi . Bu öğreticide, yapılandırılmış sinyaller oluşturarak (sentezleyerek) film incelemesi görüşlerini sınıflandırmak için grafik düzenlemenin kullanımını gösteriyoruz.

Görüntü sınıflandırması için çekişmeli öğrenme . Bu derste, sayısal rakamlar içeren görüntüleri sınıflandırmak için çekişmeli öğrenmenin (yapılandırılmış sinyallerin tetiklendiği yerde) kullanımını araştırıyoruz.

Daha fazla örnek ve öğreticiyi GitHub depomuzun örnekler dizininde bulabilirsiniz.