Los detectores de objetos pueden identificar cuáles de un conjunto conocido de objetos podrían estar presentes y proporcionar información sobre sus posiciones dentro de una imagen determinada o una secuencia de vídeo. Un detector de objetos está entrenado para detectar la presencia y ubicación de múltiples clases de objetos. Por ejemplo, un modelo podría entrenarse con imágenes que contengan varias piezas de fruta, junto con una etiqueta que especifique la clase de fruta que representan (por ejemplo, una manzana, un plátano o una fresa) y datos que especifiquen dónde aparece cada objeto. la imagen. Consulte la introducción a la detección de objetos para obtener más información sobre los detectores de objetos.

Utilice la API ObjectDetector de la biblioteca de tareas para implementar sus detectores de objetos personalizados o previamente entrenados en sus aplicaciones móviles.

Características clave de la API ObjectDetector

Procesamiento de imágenes de entrada, incluida la rotación, el cambio de tamaño y la conversión del espacio de color.

Localización del mapa de etiquetas.

Umbral de puntuación para filtrar resultados.

Resultados de detección top-k.

Etiquetar lista permitida y lista denegada.

Modelos de detectores de objetos compatibles

Se garantiza que los siguientes modelos serán compatibles con la API ObjectDetector .

Los modelos de detección de objetos previamente entrenados en TensorFlow Hub .

Modelos creados por AutoML Vision Edge Object Detección .

Modelos creados por TensorFlow Lite Model Maker para detector de objetos .

Modelos personalizados que cumplen con los requisitos de compatibilidad de modelos .

Ejecutar inferencia en Java

Consulte la aplicación de referencia de Detección de objetos para ver un ejemplo de cómo usar ObjectDetector en una aplicación de Android.

Paso 1: importar la dependencia de Gradle y otras configuraciones

Copie el archivo del modelo .tflite en el directorio de activos del módulo de Android donde se ejecutará el modelo. Especifique que el archivo no debe comprimirse y agregue la biblioteca TensorFlow Lite al archivo build.gradle del módulo:

android {

// Other settings

// Specify tflite file should not be compressed for the app apk

aaptOptions {

noCompress "tflite"

}

}

dependencies {

// Other dependencies

// Import the Task Vision Library dependency (NNAPI is included)

implementation 'org.tensorflow:tensorflow-lite-task-vision'

// Import the GPU delegate plugin Library for GPU inference

implementation 'org.tensorflow:tensorflow-lite-gpu-delegate-plugin'

}

Paso 2: usar el modelo

// Initialization

ObjectDetectorOptions options =

ObjectDetectorOptions.builder()

.setBaseOptions(BaseOptions.builder().useGpu().build())

.setMaxResults(1)

.build();

ObjectDetector objectDetector =

ObjectDetector.createFromFileAndOptions(

context, modelFile, options);

// Run inference

List<Detection> results = objectDetector.detect(image);

Consulte el código fuente y javadoc para obtener más opciones para configurar ObjectDetector .

Ejecutar inferencia en iOS

Paso 1: instalar las dependencias

La biblioteca de tareas admite la instalación mediante CocoaPods. Asegúrese de que CocoaPods esté instalado en su sistema. Consulte la guía de instalación de CocoaPods para obtener instrucciones.

Consulte la guía CocoaPods para obtener detalles sobre cómo agregar pods a un proyecto Xcode.

Agregue el pod TensorFlowLiteTaskVision en el Podfile.

target 'MyAppWithTaskAPI' do

use_frameworks!

pod 'TensorFlowLiteTaskVision'

end

Asegúrese de que el modelo .tflite que utilizará para la inferencia esté presente en el paquete de su aplicación.

Paso 2: usar el modelo

Rápido

// Imports

import TensorFlowLiteTaskVision

// Initialization

guard let modelPath = Bundle.main.path(forResource: "ssd_mobilenet_v1",

ofType: "tflite") else { return }

let options = ObjectDetectorOptions(modelPath: modelPath)

// Configure any additional options:

// options.classificationOptions.maxResults = 3

let detector = try ObjectDetector.detector(options: options)

// Convert the input image to MLImage.

// There are other sources for MLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

guard let image = UIImage (named: "cats_and_dogs.jpg"), let mlImage = MLImage(image: image) else { return }

// Run inference

let detectionResult = try detector.detect(mlImage: mlImage)

C objetivo

// Imports

#import <TensorFlowLiteTaskVision/TensorFlowLiteTaskVision.h>

// Initialization

NSString *modelPath = [[NSBundle mainBundle] pathForResource:@"ssd_mobilenet_v1" ofType:@"tflite"];

TFLObjectDetectorOptions *options = [[TFLObjectDetectorOptions alloc] initWithModelPath:modelPath];

// Configure any additional options:

// options.classificationOptions.maxResults = 3;

TFLObjectDetector *detector = [TFLObjectDetector objectDetectorWithOptions:options

error:nil];

// Convert the input image to MLImage.

UIImage *image = [UIImage imageNamed:@"dogs.jpg"];

// There are other sources for GMLImage. For more details, please see:

// https://developers.google.com/ml-kit/reference/ios/mlimage/api/reference/Classes/GMLImage

GMLImage *gmlImage = [[GMLImage alloc] initWithImage:image];

// Run inference

TFLDetectionResult *detectionResult = [detector detectWithGMLImage:gmlImage error:nil];

Consulte el código fuente para obtener más opciones para configurar TFLObjectDetector .

Ejecutar inferencia en Python

Paso 1: instale el paquete pip

pip install tflite-support

Paso 2: usar el modelo

# Imports

from tflite_support.task import vision

from tflite_support.task import core

from tflite_support.task import processor

# Initialization

base_options = core.BaseOptions(file_name=model_path)

detection_options = processor.DetectionOptions(max_results=2)

options = vision.ObjectDetectorOptions(base_options=base_options, detection_options=detection_options)

detector = vision.ObjectDetector.create_from_options(options)

# Alternatively, you can create an object detector in the following manner:

# detector = vision.ObjectDetector.create_from_file(model_path)

# Run inference

image = vision.TensorImage.create_from_file(image_path)

detection_result = detector.detect(image)

Consulte el código fuente para obtener más opciones para configurar ObjectDetector .

Ejecutar inferencia en C++

// Initialization

ObjectDetectorOptions options;

options.mutable_base_options()->mutable_model_file()->set_file_name(model_path);

std::unique_ptr<ObjectDetector> object_detector = ObjectDetector::CreateFromOptions(options).value();

// Create input frame_buffer from your inputs, `image_data` and `image_dimension`.

// See more information here: tensorflow_lite_support/cc/task/vision/utils/frame_buffer_common_utils.h

std::unique_ptr<FrameBuffer> frame_buffer = CreateFromRgbRawBuffer(

image_data, image_dimension);

// Run inference

const DetectionResult result = object_detector->Detect(*frame_buffer).value();

Consulte el código fuente para obtener más opciones para configurar ObjectDetector .

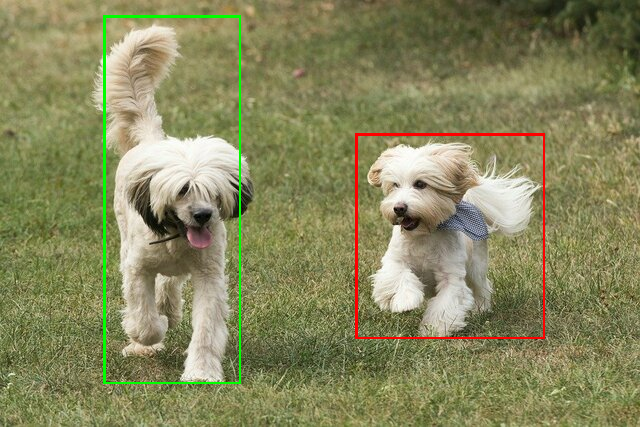

Resultados de ejemplo

A continuación se muestra un ejemplo de los resultados de la detección de ssd mobilenet v1 de TensorFlow Hub.

Results:

Detection #0 (red):

Box: (x: 355, y: 133, w: 190, h: 206)

Top-1 class:

index : 17

score : 0.73828

class name : dog

Detection #1 (green):

Box: (x: 103, y: 15, w: 138, h: 369)

Top-1 class:

index : 17

score : 0.73047

class name : dog

Renderice los cuadros delimitadores en la imagen de entrada:

Pruebe la sencilla herramienta de demostración CLI para ObjectDetector con su propio modelo y datos de prueba.

Requisitos de compatibilidad del modelo

La API ObjectDetector espera un modelo TFLite con metadatos del modelo TFLite obligatorios. Vea ejemplos de creación de metadatos para detectores de objetos utilizando la API de escritura de metadatos de TensorFlow Lite .

Los modelos de detectores de objetos compatibles deben cumplir los siguientes requisitos:

Tensor de imagen de entrada: (kTfLiteUInt8/kTfLiteFloat32)

- entrada de imagen de tamaño

[batch x height x width x channels]. - No se admite la inferencia por lotes (se requiere que

batchsea 1). - Solo se admiten entradas RGB (se requieren 3

channels). - si el tipo es kTfLiteFloat32, es necesario adjuntar NormalizationOptions a los metadatos para la normalización de la entrada.

- entrada de imagen de tamaño

Los tensores de salida deben ser las 4 salidas de una

DetectionPostProcess, es decir:- Tensor de ubicaciones (kTfLiteFloat32)

- tensor de tamaño

[1 x num_results x 4], la matriz interna representa cuadros delimitadores en la forma [arriba, izquierda, derecha, abajo]. - Es necesario adjuntar BoundingBoxProperties a los metadatos y deben especificar

type=BOUNDARIESy `coordinate_type=RATIO.

- tensor de tamaño

Tensor de clases (kTfLiteFloat32)

- tensor de tamaño

[1 x num_results], cada valor representa el índice entero de una clase. - Los mapas de etiquetas opcionales (pero recomendados) se pueden adjuntar como AssociatedFile-s con tipo TENSOR_VALUE_LABELS, que contienen una etiqueta por línea. Vea el archivo de etiqueta de ejemplo . El primer AssociatedFile (si lo hay) se utiliza para completar el campo

class_namede los resultados. El campodisplay_namese completa desde AssociatedFile (si lo hay) cuya configuración regional coincide con el campodisplay_names_localedeObjectDetectorOptionsutilizado en el momento de la creación ("en" de forma predeterminada, es decir, inglés). Si ninguno de estos está disponible, solo se completará el campoindexde los resultados.

- tensor de tamaño

Tensor de puntuaciones (kTfLiteFloat32)

- tensor de tamaño

[1 x num_results], cada valor representa la puntuación del objeto detectado.

- tensor de tamaño

Número de tensor de detección (kTfLiteFloat32)

- entero num_results como tensor de tamaño

[1].

- entero num_results como tensor de tamaño

- Tensor de ubicaciones (kTfLiteFloat32)