आर्म एमएल टूलींग द्वारा बनाए रखा गया

यह दस्तावेज़ तैनाती के लिए मशीन लर्निंग मॉडल को अनुकूलित करने के लिए विभिन्न तकनीकों के संयोजन के लिए प्रयोगात्मक एपीआई का अवलोकन प्रदान करता है।

अवलोकन

सहयोगात्मक अनुकूलन एक व्यापक प्रक्रिया है जिसमें एक मॉडल तैयार करने के लिए विभिन्न तकनीकों को शामिल किया जाता है, जो तैनाती पर, अनुमान गति, मॉडल आकार और सटीकता जैसी लक्ष्य विशेषताओं का सर्वोत्तम संतुलन प्रदर्शित करता है।

सहयोगात्मक अनुकूलन का विचार संचित अनुकूलन प्रभाव को प्राप्त करने के लिए व्यक्तिगत तकनीकों को एक के बाद एक लागू करके उनका निर्माण करना है। निम्नलिखित अनुकूलन के विभिन्न संयोजन संभव हैं:

- वजन छंटाई

- वजन क्लस्टरिंग

परिमाणीकरण

इन तकनीकों को एक साथ जोड़ने का प्रयास करते समय जो मुद्दा उठता है वह यह है कि किसी एक को लागू करने से आम तौर पर पिछली तकनीक के परिणाम नष्ट हो जाते हैं, जिससे उन सभी को एक साथ लागू करने का समग्र लाभ खराब हो जाता है; उदाहरण के लिए, क्लस्टरिंग प्रूनिंग एपीआई द्वारा शुरू की गई विरलता को संरक्षित नहीं करती है। इस समस्या को हल करने के लिए, हम निम्नलिखित प्रयोगात्मक सहयोगात्मक अनुकूलन तकनीकों का परिचय देते हैं:

- स्पार्सिटी संरक्षण क्लस्टरिंग

- स्पार्सिटी संरक्षण परिमाणीकरण जागरूक प्रशिक्षण (पीक्यूएटी)

- क्लस्टर संरक्षण परिमाणीकरण जागरूक प्रशिक्षण (सीक्यूएटी)

- स्पार्सिटी और क्लस्टर संरक्षण परिमाणीकरण जागरूक प्रशिक्षण

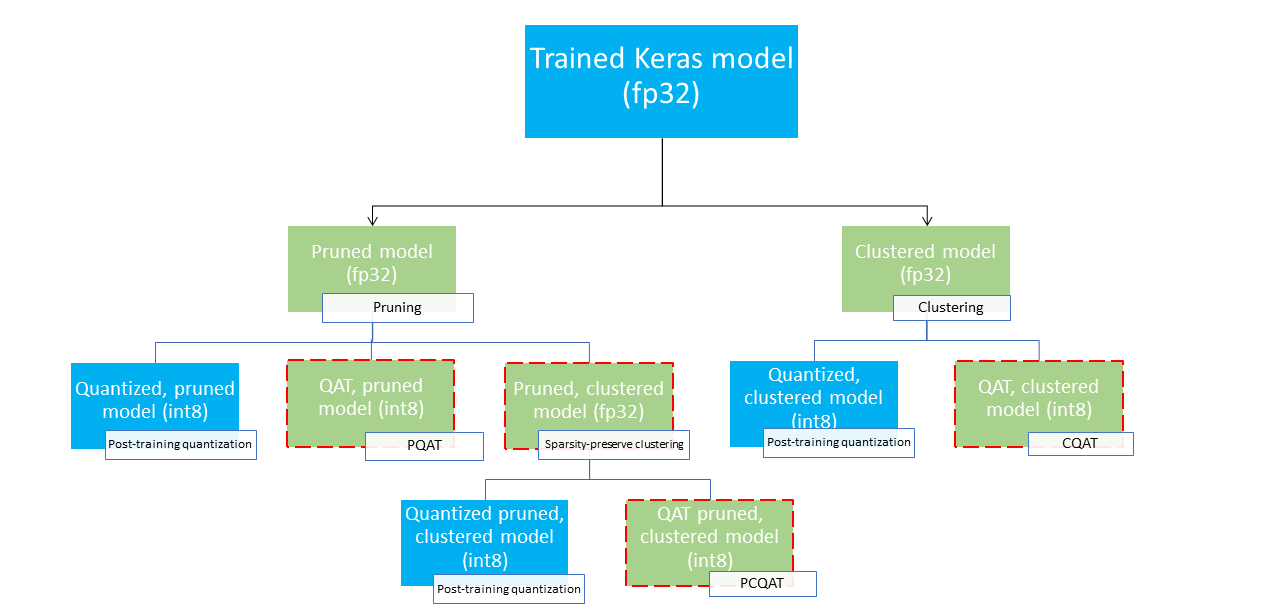

ये कई परिनियोजन पथ प्रदान करते हैं जिनका उपयोग मशीन लर्निंग मॉडल को संपीड़ित करने और अनुमान के समय हार्डवेयर त्वरण का लाभ उठाने के लिए किया जा सकता है। नीचे दिया गया चित्र कई परिनियोजन पथों को दर्शाता है जिन्हें वांछित परिनियोजन विशेषताओं वाले मॉडल की खोज में खोजा जा सकता है, जहां लीफ नोड्स परिनियोजन-तैयार मॉडल हैं, जिसका अर्थ है कि वे आंशिक रूप से या पूरी तरह से मात्राबद्ध हैं और टीएफलाइट प्रारूप में हैं। हरा भराव उन चरणों को इंगित करता है जहां पुनर्प्रशिक्षण/फाइन-ट्यूनिंग की आवश्यकता होती है और एक धराशायी लाल बॉर्डर सहयोगात्मक अनुकूलन चरणों को उजागर करता है। किसी दिए गए नोड पर एक मॉडल प्राप्त करने के लिए उपयोग की जाने वाली तकनीक को संबंधित लेबल में दर्शाया गया है।

उपरोक्त चित्र में प्रत्यक्ष, केवल परिमाणीकरण (प्रशिक्षण के बाद या QAT) परिनियोजन पथ को छोड़ दिया गया है।

उपरोक्त परिनियोजन ट्री के तीसरे स्तर पर पूरी तरह से अनुकूलित मॉडल तक पहुंचने का विचार है; हालाँकि, अनुकूलन का कोई भी अन्य स्तर संतोषजनक साबित हो सकता है और आवश्यक अनुमान विलंबता/सटीकता व्यापार-बंद प्राप्त कर सकता है, जिस स्थिति में किसी और अनुकूलन की आवश्यकता नहीं है। अनुशंसित प्रशिक्षण प्रक्रिया लक्ष्य परिनियोजन परिदृश्य पर लागू परिनियोजन ट्री के स्तरों के माध्यम से पुनरावृत्त रूप से जाना होगा और देखना होगा कि क्या मॉडल अनुमान विलंबता आवश्यकताओं को पूरा करता है और यदि नहीं, तो मॉडल को आगे संपीड़ित करने और दोहराने के लिए संबंधित सहयोगी अनुकूलन तकनीक का उपयोग करें। जब तक कि जरूरत पड़ने पर मॉडल पूरी तरह से अनुकूलित (कांट-छांट, क्लस्टर और परिमाणित) न हो जाए।

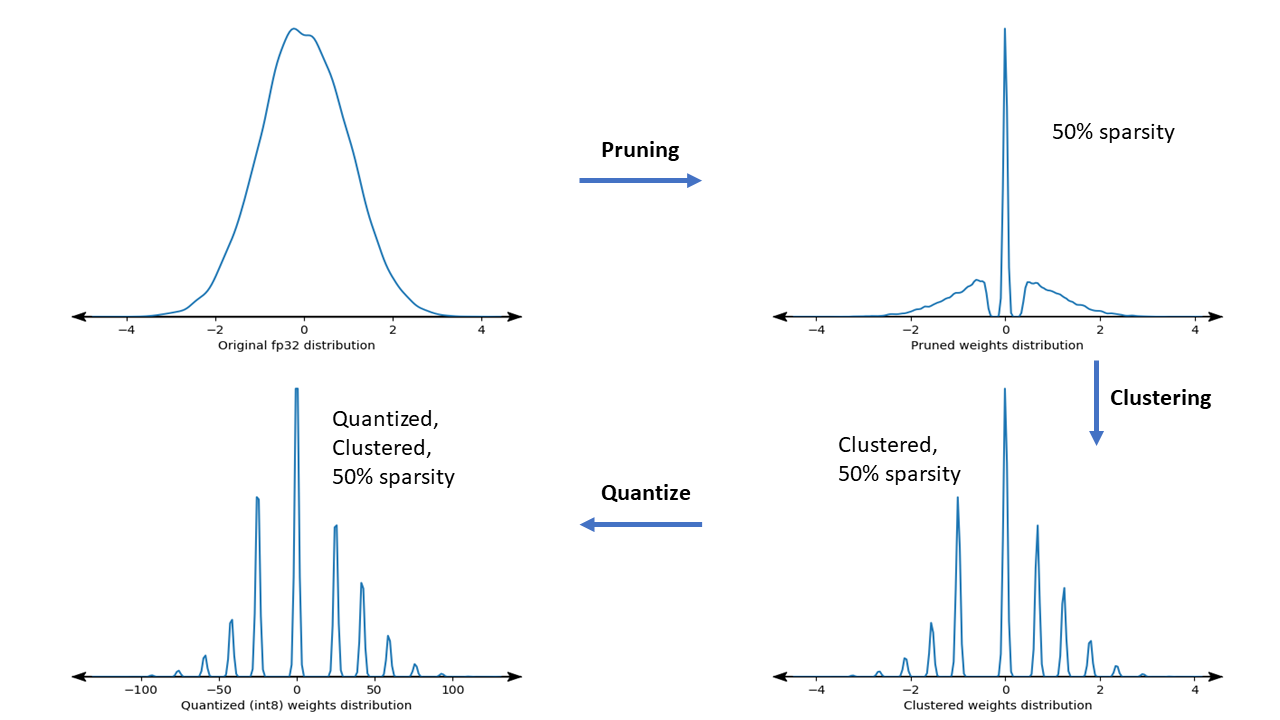

नीचे दिया गया आंकड़ा सहयोगी अनुकूलन पाइपलाइन के माध्यम से जाने वाले नमूना वजन कर्नेल के घनत्व प्लॉट को दर्शाता है।

परिणाम एक परिमाणित परिनियोजन मॉडल है जिसमें प्रशिक्षण के समय निर्दिष्ट लक्ष्य विरलता के आधार पर अद्वितीय मूल्यों की कम संख्या के साथ-साथ विरल भार की एक महत्वपूर्ण संख्या होती है। महत्वपूर्ण मॉडल संपीड़न लाभों के अलावा, विशिष्ट हार्डवेयर समर्थन अनुमान विलंबता को काफी कम करने के लिए इन विरल, क्लस्टर मॉडल का लाभ उठा सकता है।

परिणाम

नीचे कुछ सटीकता और संपीड़न परिणाम दिए गए हैं जो हमें PQAT और CQAT सहयोगी अनुकूलन पथों के साथ प्रयोग करते समय प्राप्त हुए।

विरलता-संरक्षण परिमाणीकरण जागरूक प्रशिक्षण (पीक्यूएटी)

| नमूना | सामान | आधारभूत | काटा गया मॉडल (50% विरलता) | क्यूएटी मॉडल | पीक्यूएटी मॉडल |

|---|---|---|---|---|---|

| डीएस-सीएनएन-एल | एफपी32 टॉप1 सटीकता | 95.23% | 94.80% | (नकली INT8) 94.721% | (नकली INT8) 94.128% |

| INT8 पूर्ण पूर्णांक परिमाणीकरण | 94.48% | 93.80% | 94.72% | 94.13% | |

| दबाव | 528,128 → 434,879 (17.66%) | 528,128 → 334,154 (36.73%) | 512,224 → 403,261 (21.27%) | 512,032 → 303,997 (40.63%) | |

| मोबाइलनेट_v1-224 | एफपी32 शीर्ष 1 सटीकता | 70.99% | 70.11% | (नकली INT8) 70.67% | (नकली INT8) 70.29% |

| INT8 पूर्ण पूर्णांक परिमाणीकरण | 69.37% | 67.82% | 70.67% | 70.29% | |

| दबाव | 4,665,520 → 3,880,331 (16.83%) | 4,665,520 → 2,939,734 (37.00%) | 4,569,416 → 3,808,781 (16.65%) | 4,569,416 → 2,869,600 (37.20%) |

क्लस्टर-संरक्षण परिमाणीकरण जागरूक प्रशिक्षण (सीक्यूएटी)

| नमूना | सामान | आधारभूत | क्लस्टर्ड मॉडल | क्यूएटी मॉडल | सीक्यूएटी मॉडल |

|---|---|---|---|---|---|

| CIFAR-10 पर Mobilenet_v1 | एफपी32 टॉप1 सटीकता | 94.88% | 94.48% | (नकली INT8) 94.80% | (नकली INT8) 94.60% |

| INT8 पूर्ण पूर्णांक परिमाणीकरण | 94.65% | 94.41% | 94.77% | 94.52% | |

| आकार | 3.00 एमबी | 2.00 एमबी | 2.84 एमबी | 1.94 एमबी | |

| ImageNet पर Mobilenet_v1 | एफपी32 शीर्ष 1 सटीकता | 71.07% | 65.30% | (नकली INT8) 70.39% | (नकली INT8) 65.35% |

| INT8 पूर्ण पूर्णांक परिमाणीकरण | 69.34% | 60.60% | 70.35% | 65.42% | |

| दबाव | 4,665,568 → 3,886,277 (16.7%) | 4,665,568 → 3,035,752 (34.9%) | 4,569,416 → 3,804,871 (16.7%) | 4,569,472 → 2,912,655 (36.25%) |

प्रति चैनल क्लस्टर किए गए मॉडल के लिए CQAT और PCQAT परिणाम

नीचे दिए गए परिणाम प्रति चैनल क्लस्टरिंग तकनीक से प्राप्त किए गए हैं। वे स्पष्ट करते हैं कि यदि मॉडल की संकेंद्रित परतें प्रति चैनल क्लस्टर की जाती हैं, तो मॉडल सटीकता अधिक होती है। यदि आपके मॉडल में कई संकेंद्रित परतें हैं, तो हम प्रति चैनल क्लस्टर करने की अनुशंसा करते हैं। संपीड़न अनुपात समान रहता है, लेकिन मॉडल सटीकता अधिक होगी। हमारे प्रयोगों में मॉडल अनुकूलन पाइपलाइन 'क्लस्टर -> क्लस्टर संरक्षित QAT -> प्रशिक्षण के बाद परिमाणीकरण, int8' है। नमूना क्लस्टर्ड -> CQAT, int8 परिमाणित प्रति चैनल क्लस्टर्ड -> CQAT, int8 परिमाणित डीएस-सीएनएन-एल 95.949% 96.44% मोबाइलनेट-V2 71.538% 72.638% मोबाइलनेट-V2 (कांट-छांट) 71.45% 71.901%

उदाहरण

यहां वर्णित सहयोगात्मक अनुकूलन तकनीकों के अंत-से-अंत उदाहरणों के लिए, कृपया CQAT , PQAT , विरलता-संरक्षण क्लस्टरिंग , और PCQAT उदाहरण नोटबुक देखें।