- 説明:

Places データセットは、人間の視覚認識の原則に従って設計されています。私たちの目標は、シーン コンテキスト、オブジェクト認識、アクションとイベントの予測、理論による推論など、高レベルの視覚的理解タスクのために人工システムをトレーニングするために使用できる視覚的知識のコアを構築することです。

場所のセマンティック カテゴリは、その機能によって定義されます。ラベルは、環境のエントリ レベルを表します。説明すると、データセットには寝室や通りなどのさまざまなカテゴリがあります。これは、家の寝室、ホテルの寝室、または子供部屋で同じように行動したり、次に何が起こるかについて同じ予測を行ったりしないためです。 Places には、400 以上のユニークなシーン カテゴリからなる 1,000 万枚を超える画像が含まれています。このデータセットには、クラスごとに 5000 から 30,000 のトレーニング画像が含まれており、実際の発生頻度と一致しています。 Places データセットは、畳み込みニューラル ネットワーク (CNN) を使用して、シーン中心のベンチマークで新しい最先端のパフォーマンスを確立することを目標に、さまざまなシーン認識タスクのディープ シーン機能の学習を可能にします。

ここでは、学術研究および教育目的で Places Database とトレーニング済み CNN を提供しています。

ホームページ: http://places2.csail.mit.edu/

ソースコード:

tfds.datasets.placesfull.Builderバージョン:

-

1.0.0(デフォルト): リリース ノートはありません。

-

ダウンロードサイズ:

143.56 GiBデータセットサイズ:

136.56 GiB自動キャッシュ(ドキュメント): いいえ

スプリット:

| スプリット | 例 |

|---|---|

'train' | 10,653,087 |

- 機能構造:

FeaturesDict({

'filename': Text(shape=(), dtype=string),

'image': Image(shape=(256, 256, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=435),

})

- 機能のドキュメント:

| 特徴 | クラス | 形 | Dtype | 説明 |

|---|---|---|---|---|

| 特徴辞書 | ||||

| ファイル名 | 文章 | ストリング | ||

| 画像 | 画像 | (256, 256, 3) | uint8 | |

| ラベル | クラスラベル | int64 |

監視されたキー(

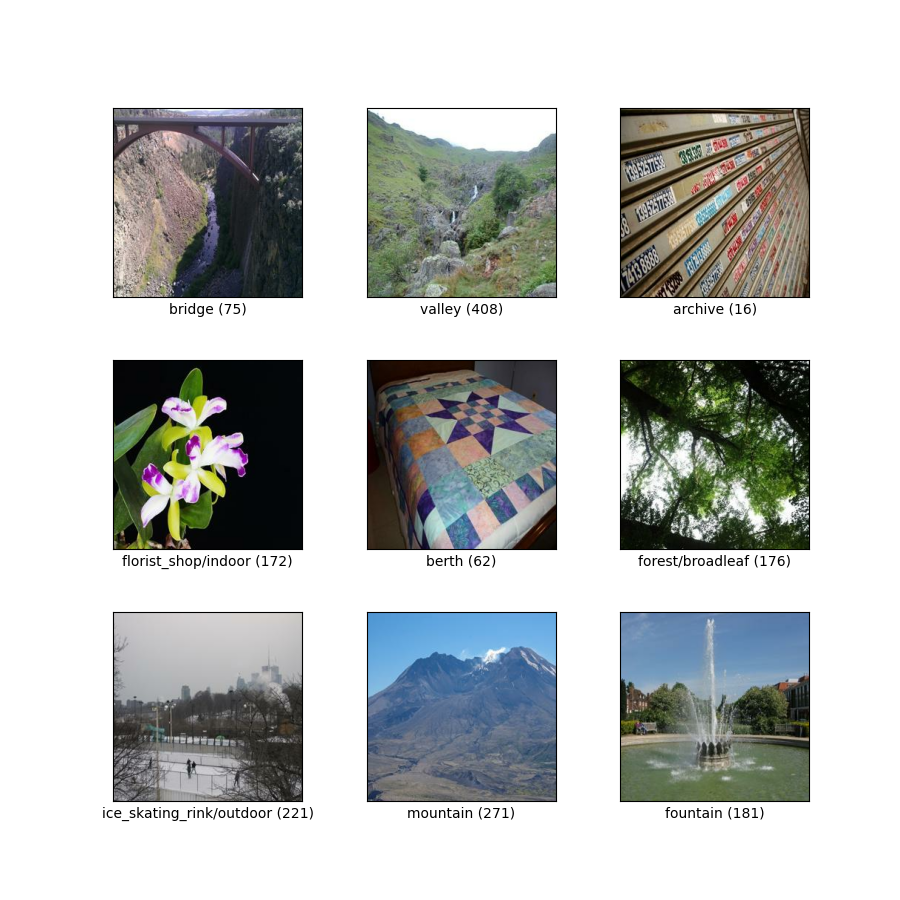

as_superviseddocを参照):('image', 'label', 'filename')図( tfds.show_examples ):

- 例( tfds.as_dataframe ):

- 引用:

@article{zhou2017places,

title={Places: A 10 million Image Database for Scene Recognition},

author={Zhou, Bolei and Lapedriza, Agata and Khosla, Aditya and Oliva, Aude and Torralba, Antonio},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2017},

publisher={IEEE}

}