- Descrição :

Uma coleção de 3 conjuntos de dados de expressão de referência baseados em imagens no conjunto de dados COCO. Uma expressão de referência é um pedaço de texto que descreve um objeto único em uma imagem. Esses conjuntos de dados são coletados solicitando aos avaliadores humanos que desambiguam objetos delineados por caixas delimitadoras no conjunto de dados COCO.

RefCoco e RefCoco+ são de Kazemzadeh et al. 2014. As expressões RefCoco+ são estritamente descrições baseadas na aparência, que são aplicadas impedindo que os avaliadores usem descrições baseadas em localização (por exemplo, "pessoa à direita" não é uma descrição válida para RefCoco+). RefCocoG é de Mao et al. 2016, e tem descrição mais rica de objetos em comparação com RefCoco devido a diferenças no processo de anotação. Em particular, RefCoco foi coletado em um ambiente baseado em jogo interativo, enquanto RefCocoG foi coletado em um ambiente não interativo. Em média, RefCocoG tem 8,4 palavras por expressão enquanto RefCoco tem 3,5 palavras.

Cada conjunto de dados tem diferentes alocações divididas que geralmente são relatadas em documentos. Os conjuntos "testA" e "testB" em RefCoco e RefCoco+ contêm apenas pessoas e apenas não-pessoas, respectivamente. As imagens são particionadas em várias divisões. Na divisão "google", os objetos, não as imagens, são particionados entre as divisões train e non-train. Isso significa que a mesma imagem pode aparecer na divisão de treinamento e validação, mas os objetos referidos na imagem serão diferentes entre os dois conjuntos. Em contraste, o "unc" e o "umd" dividem as imagens de partição entre o treinamento, a validação e a divisão de teste. No RefCocoG, a divisão "google" não possui um conjunto de teste canônico e o conjunto de validação é normalmente relatado em artigos como "val*".

Estatísticas para cada conjunto de dados e divisão ("refs" é o número de expressões de referência e "images" é o número de imagens):

| conjunto de dados | partição | dividir | referências | imagens |

|---|---|---|---|---|

| refcoco | o Google | Comboio | 40000 | 19213 |

| refcoco | o Google | val | 5000 | 4559 |

| refcoco | o Google | teste | 5000 | 4527 |

| refcoco | unc | Comboio | 42404 | 16994 |

| refcoco | unc | val | 3811 | 1500 |

| refcoco | unc | testa | 1975 | 750 |

| refcoco | unc | testeB | 1810 | 750 |

| refcoco+ | unc | Comboio | 42278 | 16992 |

| refcoco+ | unc | val | 3805 | 1500 |

| refcoco+ | unc | testa | 1975 | 750 |

| refcoco+ | unc | testeB | 1798 | 750 |

| refcocog | o Google | Comboio | 44822 | 24698 |

| refcocog | o Google | val | 5000 | 4650 |

| refcocog | umd | Comboio | 42226 | 21899 |

| refcocog | umd | val | 2573 | 1300 |

| refcocog | umd | teste | 5023 | 2600 |

Documentação Adicional : Explore em Papers With Code

Página inicial : https://github.com/lichengunc/refer

Código -fonte:

tfds.datasets.ref_coco.BuilderVersões :

-

1.0.0(padrão): versão inicial.

-

Tamanho do download :

Unknown sizeInstruções de download manual : este conjunto de dados exige que você baixe os dados de origem manualmente em

download_config.manual_dir(o padrão é~/tensorflow_datasets/downloads/manual/):Siga as instruções em https://github.com/lichengunc/refer e baixe as anotações e as imagens, correspondendo ao diretório data/ especificado no repositório.

Siga as instruções do PythonAPI em https://github.com/cocodataset/cocoapi para obter pycocotools e o arquivo de anotações instances_train2014 de https://cocodataset.org/#download

Adicione refer.py de (1) e pycocotools de (2) ao seu PYTHONPATH.

Execute manual_download_process.py para gerar refcoco.json, substituindo

ref_data_root,coco_annotations_fileeout_filepelos valores correspondentes a onde você baixou/deseja salvar esses arquivos. Observe que manual_download_process.py pode ser encontrado no repositório TFDS.Baixe o conjunto de treinamento COCO em https://cocodataset.org/#download e coloque-o em uma pasta chamada

coco_train2014/. Movarefcoco.jsonpara o mesmo nível quecoco_train2014.Siga as instruções de download manual padrão.

Armazenado em cache automaticamente ( documentação ): Não

Estrutura de recursos :

FeaturesDict({

'coco_annotations': Sequence({

'area': int64,

'bbox': BBoxFeature(shape=(4,), dtype=float32),

'id': int64,

'label': int64,

}),

'image': Image(shape=(None, None, 3), dtype=uint8),

'image/id': int64,

'objects': Sequence({

'area': int64,

'bbox': BBoxFeature(shape=(4,), dtype=float32),

'gt_box_index': int64,

'id': int64,

'label': int64,

'refexp': Sequence({

'raw': Text(shape=(), dtype=string),

'refexp_id': int64,

}),

}),

})

- Documentação do recurso:

| Funcionalidade | Aula | Forma | Tipo D | Descrição |

|---|---|---|---|---|

| RecursosDict | ||||

| coco_annotations | Seqüência | |||

| coco_anotações/área | tensor | int64 | ||

| coco_annotations/bbox | Recurso BBox | (4,) | float32 | |

| coco_annotations/id | tensor | int64 | ||

| coco_annotations/rótulo | tensor | int64 | ||

| imagem | Imagem | (Nenhuma, Nenhuma, 3) | uint8 | |

| imagem/id | tensor | int64 | ||

| objetos | Seqüência | |||

| objetos/área | tensor | int64 | ||

| objetos/bbox | Recurso BBox | (4,) | float32 | |

| objetos/gt_box_index | tensor | int64 | ||

| objetos/id | tensor | int64 | ||

| objetos/rótulo | tensor | int64 | ||

| objetos/refexp | Seqüência | |||

| objetos/refexp/raw | Texto | fragmento | ||

| objetos/refexp/refexp_id | tensor | int64 |

Chaves supervisionadas (Consulte

as_superviseddoc ):NoneCitação :

@inproceedings{kazemzadeh2014referitgame,

title={Referitgame: Referring to objects in photographs of natural scenes},

author={Kazemzadeh, Sahar and Ordonez, Vicente and Matten, Mark and Berg, Tamara},

booktitle={Proceedings of the 2014 conference on empirical methods in natural language processing (EMNLP)},

pages={787--798},

year={2014}

}

@inproceedings{yu2016modeling,

title={Modeling context in referring expressions},

author={Yu, Licheng and Poirson, Patrick and Yang, Shan and Berg, Alexander C and Berg, Tamara L},

booktitle={European Conference on Computer Vision},

pages={69--85},

year={2016},

organization={Springer}

}

@inproceedings{mao2016generation,

title={Generation and Comprehension of Unambiguous Object Descriptions},

author={Mao, Junhua and Huang, Jonathan and Toshev, Alexander and Camburu, Oana and Yuille, Alan and Murphy, Kevin},

booktitle={CVPR},

year={2016}

}

@inproceedings{nagaraja2016modeling,

title={Modeling context between objects for referring expression understanding},

author={Nagaraja, Varun K and Morariu, Vlad I and Davis, Larry S},

booktitle={European Conference on Computer Vision},

pages={792--807},

year={2016},

organization={Springer}

}

ref_coco/refcoco_unc (configuração padrão)

Tamanho do conjunto de dados :

3.24 GiBDivisões :

| Dividir | Exemplos |

|---|---|

'testA' | 750 |

'testB' | 750 |

'train' | 16.994 |

'validation' | 1.500 |

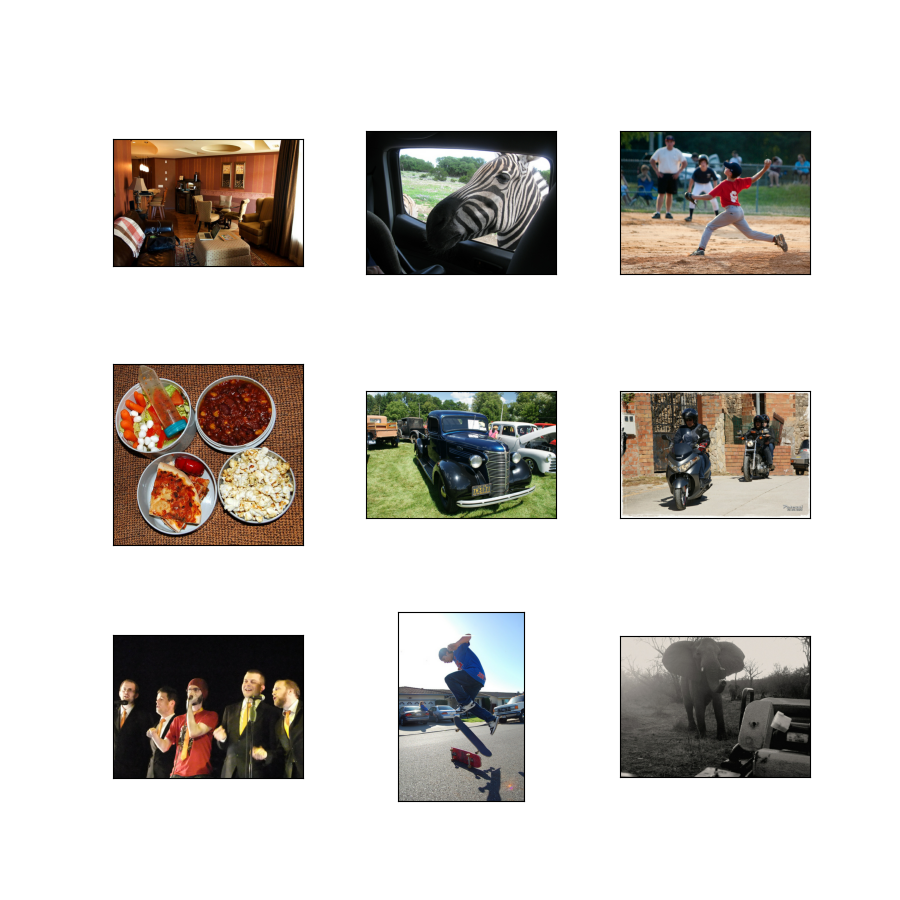

- Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):

ref_coco/refcoco_google

Tamanho do conjunto de dados :

4.60 GiBDivisões :

| Dividir | Exemplos |

|---|---|

'test' | 4.527 |

'train' | 19.213 |

'validation' | 4.559 |

- Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):

ref_coco/refcocoplus_unc

Tamanho do conjunto de dados :

3.24 GiBDivisões :

| Dividir | Exemplos |

|---|---|

'testA' | 750 |

'testB' | 750 |

'train' | 16.992 |

'validation' | 1.500 |

- Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):

ref_coco/refcocog_google

Tamanho do conjunto de dados :

4.59 GiBDivisões :

| Dividir | Exemplos |

|---|---|

'train' | 24.698 |

'validation' | 4.650 |

- Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):

ref_coco/refcocog_umd

Tamanho do conjunto de dados :

4.04 GiBDivisões :

| Dividir | Exemplos |

|---|---|

'test' | 2.600 |

'train' | 21.899 |

'validation' | 1.300 |

- Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):