- Описание :

Набор данных Places разработан в соответствии с принципами человеческого визуального восприятия. Наша цель — создать ядро визуальных знаний, которые можно использовать для обучения искусственных систем высокоуровневым задачам визуального понимания, таким как контекст сцены, распознавание объектов, предсказание действий и событий, а также логические выводы.

Семантические категории мест определяются их функцией: метки представляют начальный уровень среды. Чтобы проиллюстрировать это, в наборе данных есть разные категории спален, улиц и т. д., поскольку каждый действует по-разному и не делает одинаковых прогнозов того, что может произойти дальше, в домашней спальне, спальне отеля или детской. Всего Places содержит более 10 миллионов изображений, включающих более 400 уникальных категорий сцен. Набор данных содержит от 5000 до 30 000 обучающих изображений для каждого класса, что соответствует реальной частоте появления. Используя сверточные нейронные сети (CNN), набор данных Places позволяет изучать глубокие особенности сцены для различных задач распознавания сцены с целью установить новые современные характеристики на ориентированных на сцены тестах.

Здесь мы предоставляем базу данных Places и обученные CNN для академических исследований и образовательных целей.

Домашняя страница : http://places2.csail.mit.edu/

Исходный код :

tfds.datasets.placesfull.BuilderВерсии :

-

1.0.0(по умолчанию): нет примечаний к выпуску.

-

Размер загрузки :

143.56 GiBРазмер набора данных :

136.56 GiBАвтоматическое кэширование ( документация ): Нет

Сплиты :

| Расколоть | Примеры |

|---|---|

'train' | 10 653 087 |

- Структура функции :

FeaturesDict({

'filename': Text(shape=(), dtype=string),

'image': Image(shape=(256, 256, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=435),

})

- Документация по функциям :

| Особенность | Учебный класс | Форма | Dтип | Описание |

|---|---|---|---|---|

| ОсобенностиDict | ||||

| имя файла | Текст | нить | ||

| изображение | Изображение | (256, 256, 3) | uint8 | |

| этикетка | Метка класса | int64 |

Контролируемые ключи (см.

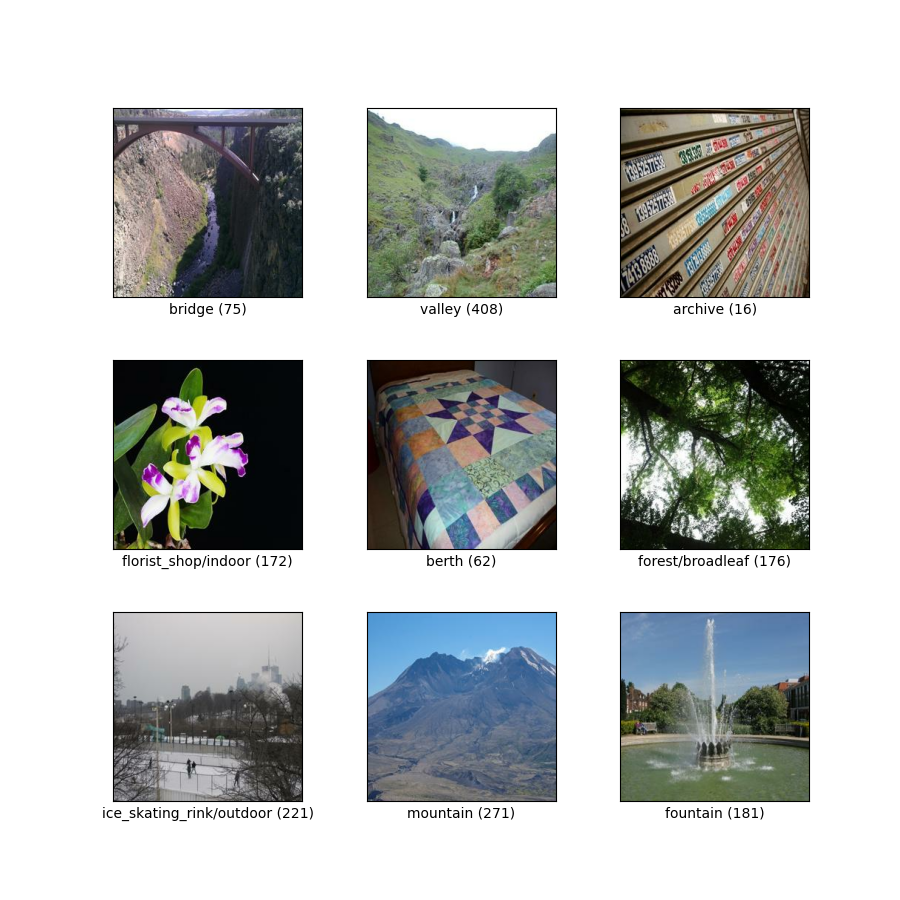

as_superviseddoc ):('image', 'label', 'filename')Рисунок ( tfds.show_examples ):

- Примеры ( tfds.as_dataframe ):

- Цитата :

@article{zhou2017places,

title={Places: A 10 million Image Database for Scene Recognition},

author={Zhou, Bolei and Lapedriza, Agata and Khosla, Aditya and Oliva, Aude and Torralba, Antonio},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2017},

publisher={IEEE}

}