- Descrição :

O conjunto de dados Places foi projetado seguindo os princípios da cognição visual humana. Nosso objetivo é construir um núcleo de conhecimento visual que possa ser usado para treinar sistemas artificiais para tarefas de compreensão visual de alto nível, como contexto de cena, reconhecimento de objetos, previsão de ações e eventos e inferência da teoria da mente.

As categorias semânticas de Locais são definidas por sua função: os rótulos representam o nível de entrada de um ambiente. Para ilustrar, o conjunto de dados tem diferentes categorias de quartos, ou ruas, etc, pois não se age da mesma maneira e não se faz as mesmas previsões do que pode acontecer a seguir, em um quarto de casa, quarto de hotel ou creche. No total, o Places contém mais de 10 milhões de imagens, abrangendo mais de 400 categorias de cenas exclusivas. O conjunto de dados apresenta de 5.000 a 30.000 imagens de treinamento por classe, consistentes com as frequências de ocorrência do mundo real. Usando redes neurais convolucionais (CNN), o conjunto de dados Places permite o aprendizado de recursos profundos de cena para várias tarefas de reconhecimento de cena, com o objetivo de estabelecer novos desempenhos de última geração em benchmarks centrados em cena.

Aqui, fornecemos o banco de dados de locais e as CNNs treinadas para fins de pesquisa acadêmica e educação.

Página inicial : http://places2.csail.mit.edu/

Código -fonte:

tfds.datasets.placesfull.BuilderVersões :

-

1.0.0(padrão): sem notas de versão.

-

Tamanho do download :

143.56 GiBTamanho do conjunto de dados :

136.56 GiBArmazenado em cache automaticamente ( documentação ): Não

Divisões :

| Dividir | Exemplos |

|---|---|

'train' | 10.653.087 |

- Estrutura de recursos :

FeaturesDict({

'filename': Text(shape=(), dtype=string),

'image': Image(shape=(256, 256, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=435),

})

- Documentação do recurso:

| Característica | Classe | Forma | Tipo D | Descrição |

|---|---|---|---|---|

| RecursosDict | ||||

| nome do arquivo | Texto | corda | ||

| imagem | Imagem | (256, 256, 3) | uint8 | |

| etiqueta | ClassLabel | int64 |

Chaves supervisionadas (Consulte

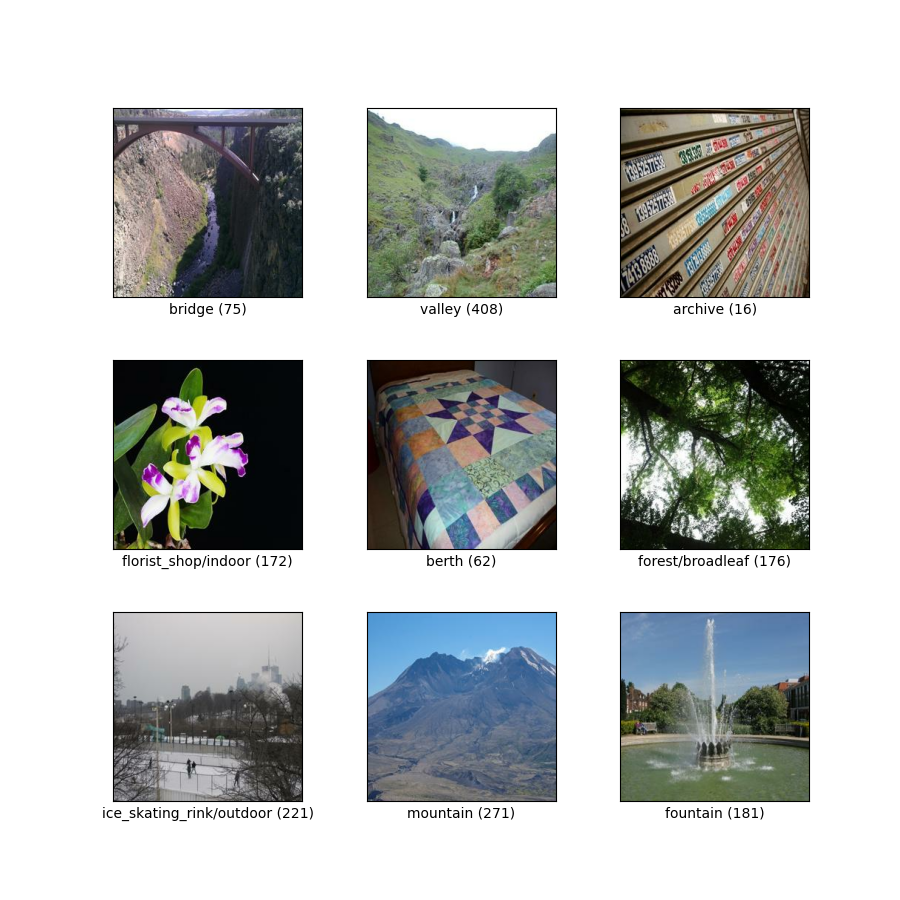

as_superviseddoc ):('image', 'label', 'filename')Figura ( tfds.show_examples ):

- Exemplos ( tfds.as_dataframe ):

- Citação :

@article{zhou2017places,

title={Places: A 10 million Image Database for Scene Recognition},

author={Zhou, Bolei and Lapedriza, Agata and Khosla, Aditya and Oliva, Aude and Torralba, Antonio},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2017},

publisher={IEEE}

}