- Descrizione :

Il set di dati Places è progettato seguendo i principi della cognizione visiva umana. Il nostro obiettivo è costruire un nucleo di conoscenza visiva che possa essere utilizzato per addestrare sistemi artificiali per compiti di comprensione visiva di alto livello, come il contesto della scena, il riconoscimento di oggetti, la previsione di azioni ed eventi e l'inferenza della teoria della mente.

Le categorie semantiche dei Luoghi sono definite dalla loro funzione: le etichette rappresentano l'entry-level di un ambiente. Per illustrare, il set di dati ha diverse categorie di camere da letto, o strade, ecc., poiché non si agisce allo stesso modo e non si fanno le stesse previsioni su ciò che può accadere dopo, in una camera da letto di casa, in una camera d'albergo o in un asilo nido. In totale, Places contiene più di 10 milioni di immagini che comprendono oltre 400 categorie di scene uniche. Il set di dati presenta da 5000 a 30.000 immagini di addestramento per classe, coerenti con le frequenze di occorrenza del mondo reale. Utilizzando le reti neurali convoluzionali (CNN), il set di dati Places consente l'apprendimento delle caratteristiche profonde della scena per varie attività di riconoscimento della scena, con l'obiettivo di stabilire nuove prestazioni all'avanguardia su benchmark incentrati sulla scena.

Qui forniamo il database dei luoghi e le CNN addestrate per scopi di ricerca accademica e istruzione.

Pagina iniziale : http://places2.csail.mit.edu/

Codice sorgente :

tfds.datasets.placesfull.BuilderVersioni :

-

1.0.0(impostazione predefinita): nessuna nota di rilascio.

-

Dimensioni del download :

143.56 GiBDimensione del set di dati:

136.56 GiBCache automatica ( documentazione ): No

Divisioni :

| Diviso | Esempi |

|---|---|

'train' | 10.653.087 |

- Struttura delle caratteristiche :

FeaturesDict({

'filename': Text(shape=(), dtype=string),

'image': Image(shape=(256, 256, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=435),

})

- Documentazione delle funzionalità :

| Caratteristica | Classe | Forma | Tipo D | Descrizione |

|---|---|---|---|---|

| CaratteristicheDict | ||||

| nome del file | Testo | corda | ||

| Immagine | Immagine | (256, 256, 3) | uint8 | |

| etichetta | ClassLabel | int64 |

Chiavi supervisionate (vedi

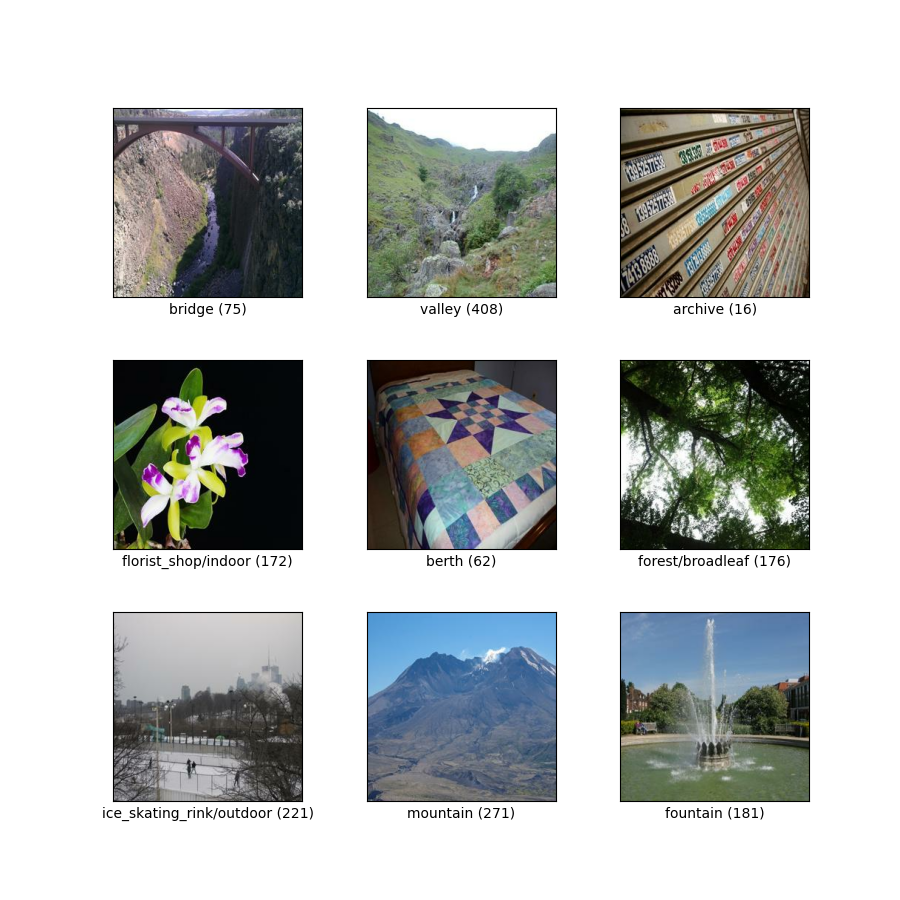

as_superviseddoc ):('image', 'label', 'filename')Figura ( tfds.show_examples ):

- Esempi ( tfds.as_dataframe ):

- Citazione :

@article{zhou2017places,

title={Places: A 10 million Image Database for Scene Recognition},

author={Zhou, Bolei and Lapedriza, Agata and Khosla, Aditya and Oliva, Aude and Torralba, Antonio},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2017},

publisher={IEEE}

}